Desafíos y perspectivas de futuro

Los coprocesadores de conocimiento cero (ZK Coprocessors) aún están en una etapa inicial de adopción. Aunque muestran un potencial considerable, existen importantes desafíos técnicos y estructurales en el ecosistema que siguen sin resolverse. Este módulo explora estos obstáculos, identifica las tendencias que señalan la evolución futura del sector y presenta las oportunidades emergentes para desarrolladores, inversores e investigadores.

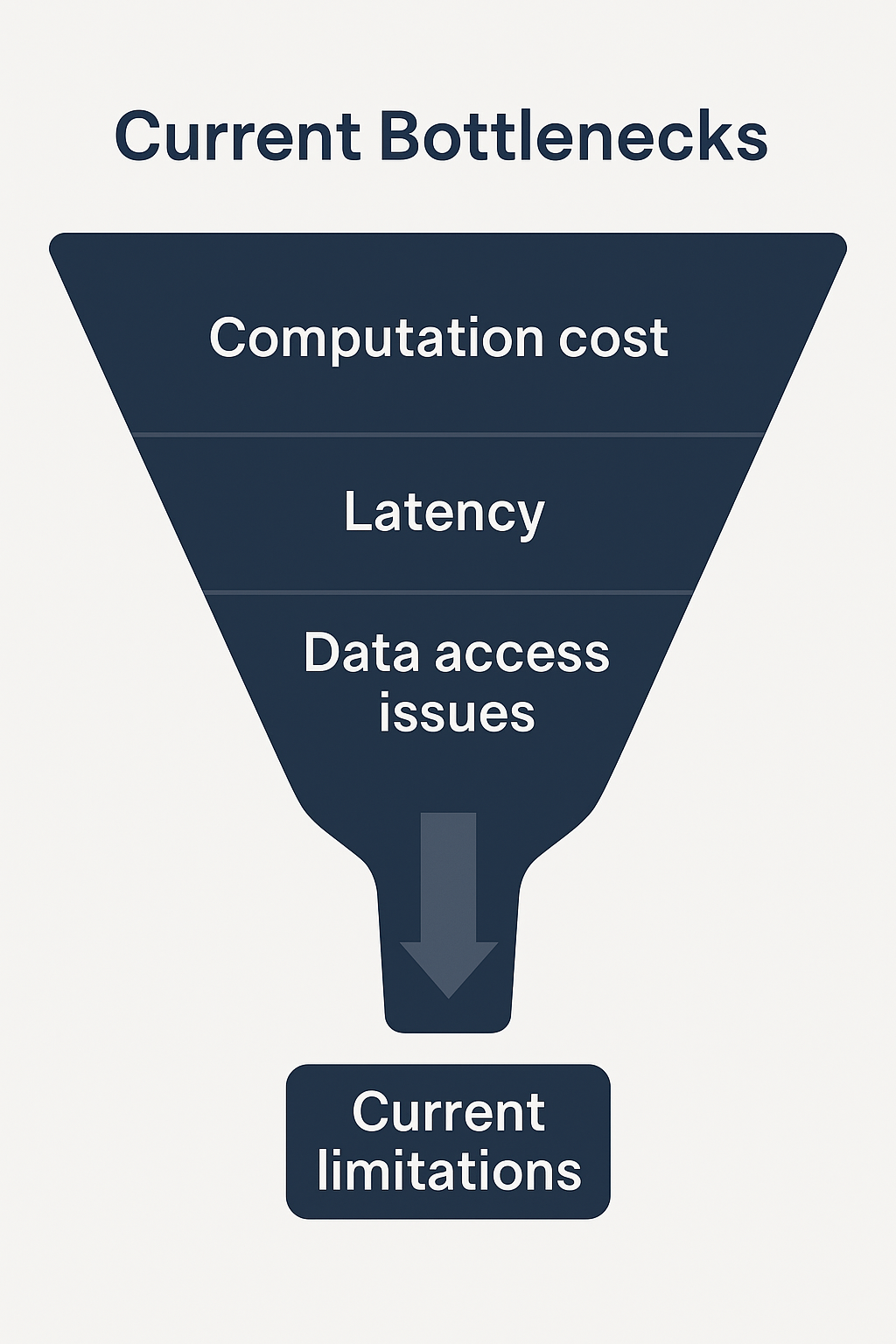

Cuellos de botella actuales

El principal reto inmediato para los coprocesadores ZK es el coste y la velocidad en la generación de pruebas. Aunque se han logrado avances notables tanto en la investigación criptográfica como en la optimización del hardware, generar pruebas de conocimiento cero para cálculos complejos puede requerir desde varios minutos hasta horas. Esta latencia resulta incompatible con aplicaciones que exigen una interacción casi en tiempo real, como los juegos descentralizados o el trading de alta frecuencia. Además, a medida que los circuitos aumentan de tamaño, también crecen los requerimientos de memoria, lo que puede resultar inasumible para redes de validadores descentralizados o dispositivos con capacidad computacional limitada.

La disponibilidad y el acceso a los datos suponen otro cuello de botella. Los coprocesadores suelen depender tanto de información histórica en la blockchain como de fuentes externas, y garantizar la veracidad demostrable de estos datos incrementa la complejidad. Los sistemas deben recurrir a pruebas Merkle, proveedores de datos fiables o enfoques híbridos que conjuguen descentralización y viabilidad práctica. Sin soluciones robustas que garanticen la integridad de los datos, el valor de las pruebas de conocimiento cero se reduce considerablemente.

Barreras de adopción

Al margen de las barreras tecnológicas, la adopción se ve ralentizada por la acentuada curva de aprendizaje para los desarrolladores. Crear aplicaciones con coprocesadores ZK exige conocimientos especializados en criptografía, diseño de circuitos y lenguajes específicos de conocimiento cero como Circom o Noir. Aunque existen esfuerzos por parte de diversas plataformas para abstraer esta complejidad, el ecosistema aún carece de marcos estandarizados y documentación completa. En consecuencia, el desarrollo sigue estando en manos de un grupo reducido de equipos altamente especializados.

Las consideraciones económicas también condicionan la adopción. La generación de pruebas, incluso en entornos optimizados, consume una cantidad considerable de recursos computacionales. Muchos proyectos minimizan este coste mediante servicios centralizados de validación, lo que introduce supuestos de confianza que van en contra del principio de verificación descentralizada. La migración a redes descentralizadas de validación requerirá incentivos, coordinación y una mayor investigación en mecanismos de consenso eficientes para la generación de pruebas.

Tendencias emergentes en investigación

La investigación sobre pruebas recursivas representa una de las líneas más prometedoras para superar las limitaciones de escalabilidad. Al anidar pruebas unas dentro de otras, los sistemas recursivos logran comprimir cálculos complejos en una única prueba sucinta, lo que permite dar soporte a casos de uso avanzados sin que aumente linealmente el coste de verificación. Esta técnica también habilita la verificación incremental de cálculos continuos o en streaming, requisito esencial para aplicaciones en tiempo real.

Otra tendencia emergente es la integración de aprendizaje automático y sistemas de conocimiento cero, conocida como zkML. Este enfoque habilita inferencia de inteligencia artificial verificable, permitiendo demostrar la corrección de los resultados de modelos de aprendizaje automático sin desvelar ni los parámetros ni los datos de entrenamiento. A medida que la IA y la blockchain convergen, los coprocesadores compatibles con zkML pueden posicionarse como elementos clave en aplicaciones que requieren privacidad y están impulsadas por inteligencia artificial.

Los avances en aceleración hardware son igualmente significativos. Los diseños de FPGA y ASIC optimizados para primitivas criptográficas, como multiplicaciones multiescalares y evaluaciones polinómicas, están reduciendo notablemente los tiempos necesarios para generar pruebas. Empresas que desarrollan hardware ZK especializado están abriendo el camino a soluciones de baja latencia y alta capacidad, especialmente en los sectores financiero y del gaming.

Papel en el ecosistema blockchain modular

El sector blockchain evoluciona hacia arquitecturas modulares donde diferentes componentes se especializan en consenso, disponibilidad de datos, ejecución y verificación. Los coprocesadores ZK encajan de forma natural en este modelo como motores específicos para verificación y computación. Pueden operar simultáneamente para varias cadenas, actuando como nodos neutrales para la validación de datos entre cadenas y la computación compleja fuera de la cadena principal.

Esta aproximación modular permite que los ecosistemas desarrollen su propia trayectoria. Un coprocesador de análisis de datos verificables puede integrarse en múltiples rollups y cadenas específicas de aplicaciones sin requerir adaptaciones personalizadas. A medida que proliferan los rollups y la interoperabilidad se convierte en un objetivo esencial, los coprocesadores despuntan como el elemento de conexión entre diferentes entornos.

Oportunidades profesionales y para desarrolladores

El auge de los coprocesadores ZK abre nuevas vías profesionales y oportunidades de financiación tanto para desarrolladores como para investigadores. La demanda de expertos en criptografía de conocimiento cero está creciendo rápidamente, y fundaciones como Ethereum Foundation, Polygon y zkSync financian activamente proyectos de investigación y desarrollo en este campo. Los hackathones centrados en tecnología de conocimiento cero ganan cada vez más relevancia, ofreciendo a los nuevos participantes experiencia directa y visibilidad.

Para los emprendedores, existen oportunidades en el desarrollo de redes especializadas de coprocesadores, soluciones middleware para pruebas de datos o herramientas que faciliten la integración de cómputo de conocimiento cero en aplicaciones ya existentes. Los inversores vigilan este ámbito de cerca, ya que perciben a los coprocesadores ZK como la base tecnológica para la próxima generación de finanzas descentralizadas, cumplimiento normativo con preservación de privacidad y comunicación entre cadenas.