PhyrexNi

用户暂无简介

PhyrexNi

美国与伊朗开战的风险上升。

- 赞赏

- 点赞

- 评论

- 转发

- 分享

谁也不知道明天和意外那个先来,今天刚刚知道之前有过一些交集,25年10月还在一起吃烤肉的小伙伴离世了,从知道病情到离世一共就12天,肝癌晚期,转移到胃了。

之前一直觉得浑身疼但也没有太在意,后来被劝的去了医院,检查出来的时候已经这样了,当时大夫说好好调理还能有一年的时间,在新加坡住院了三天就回国了。

回国去了专门的肿瘤医院,结果一周多人就没了,身边的小伙伴说是吓的,也是圈子里的,做了几个项目,还是小有名气夜场的股东,就这么没了。

体检很重要,大夫问他这起码五年了,为什么从来没有去做过检查,如果早几年不是没有的治,最起码也有缓解的机会。我认识他的时候是24年,这么来看,当时已经是癌症了,认识他的时候他就很喜欢在夜场酗酒,人很瘦,吃的东西不多。

想一想挺感慨的,赚钱很重要,但命更重要,命没了钱再多也带不走,希望小伙伴们多注意身体健康,多注意体检,活着才有机会,活得的越久机会才越大。

之前一直觉得浑身疼但也没有太在意,后来被劝的去了医院,检查出来的时候已经这样了,当时大夫说好好调理还能有一年的时间,在新加坡住院了三天就回国了。

回国去了专门的肿瘤医院,结果一周多人就没了,身边的小伙伴说是吓的,也是圈子里的,做了几个项目,还是小有名气夜场的股东,就这么没了。

体检很重要,大夫问他这起码五年了,为什么从来没有去做过检查,如果早几年不是没有的治,最起码也有缓解的机会。我认识他的时候是24年,这么来看,当时已经是癌症了,认识他的时候他就很喜欢在夜场酗酒,人很瘦,吃的东西不多。

想一想挺感慨的,赚钱很重要,但命更重要,命没了钱再多也带不走,希望小伙伴们多注意身体健康,多注意体检,活着才有机会,活得的越久机会才越大。

- 赞赏

- 点赞

- 评论

- 转发

- 分享

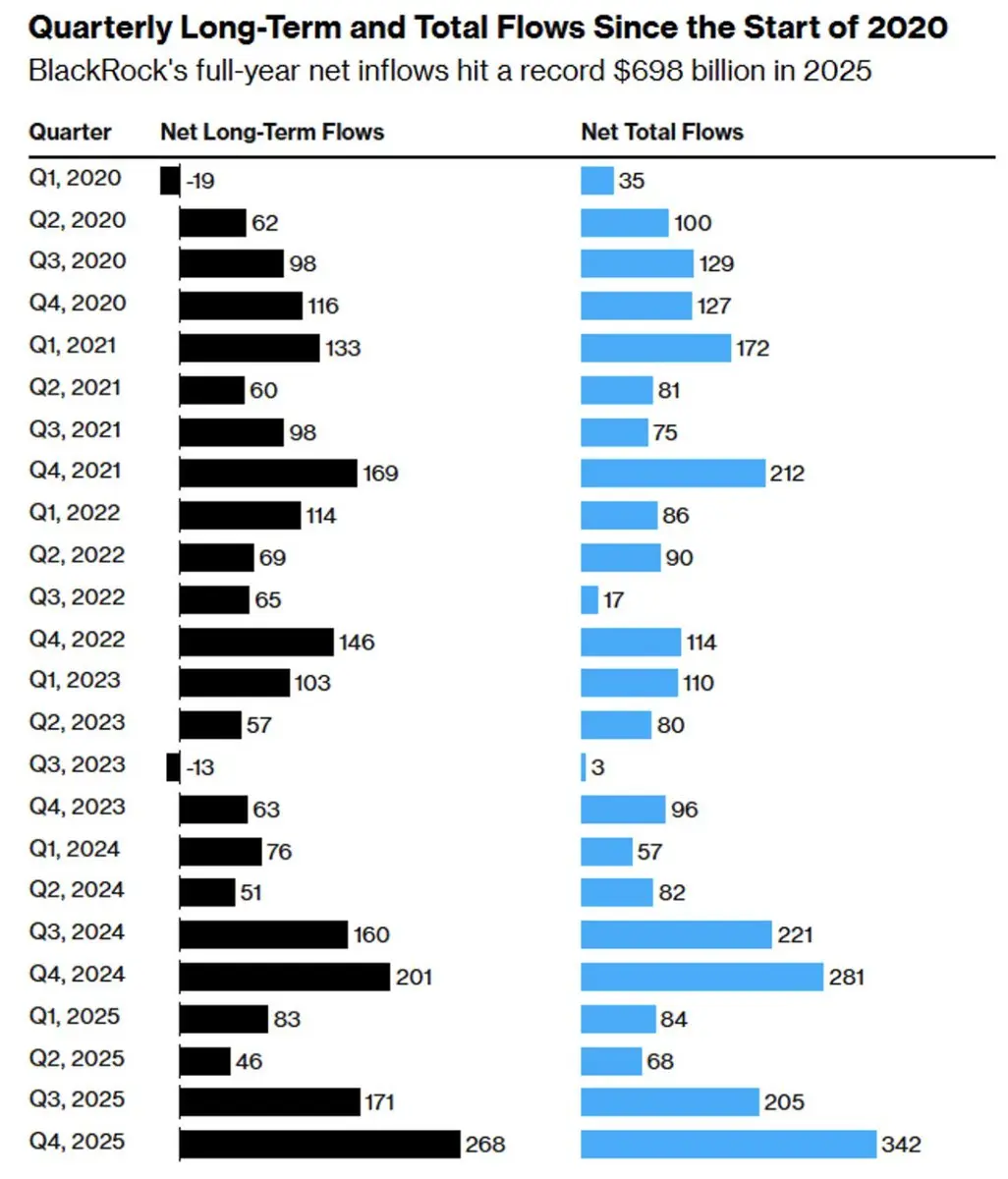

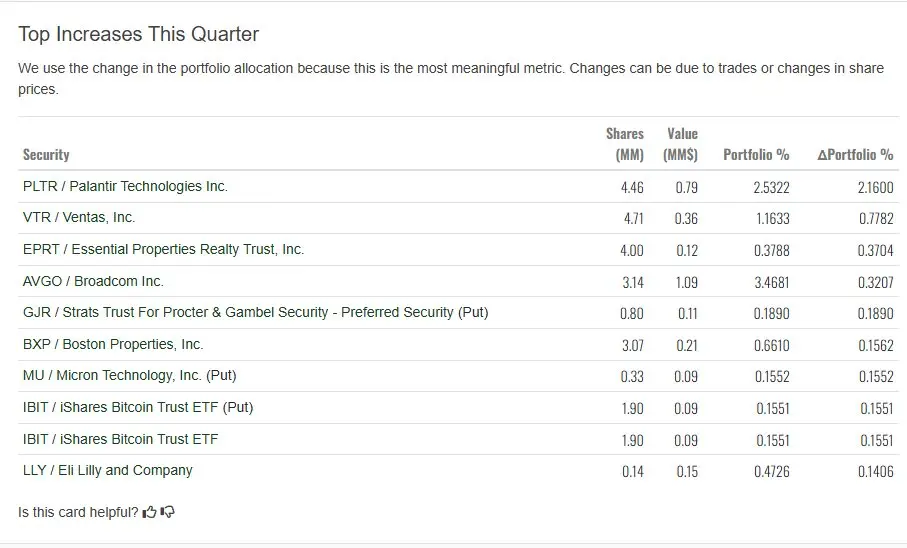

今天看到管理资产超过 2,400 亿美元的大和证券在2025年第四季度新建仓了 190万 股 $IBIT 以及 190万 股 $IBIT 的看跌期权(PUT),这是大和证券的第一次买入。

说人话就是 大和证券 买入了 190万 股的 IBIT 以后担心 $BTC 会下跌,然后对冲买入了同样 190万 股的看跌期权。

这是一种常见的保护性对冲策略,在持有资产的多头头寸,同时通过 Put 期权对冲价格下跌的风险。如果 Bitcoin 价格下跌,IBIT价值减少,但 Put 期权的价值会上升,从而部分或全部抵消损失。

这次非常感觉像大和证券试水性的建立了 Bitcoin 的敞口。

@ VIP,费率更低,福利更狠

说人话就是 大和证券 买入了 190万 股的 IBIT 以后担心 $BTC 会下跌,然后对冲买入了同样 190万 股的看跌期权。

这是一种常见的保护性对冲策略,在持有资产的多头头寸,同时通过 Put 期权对冲价格下跌的风险。如果 Bitcoin 价格下跌,IBIT价值减少,但 Put 期权的价值会上升,从而部分或全部抵消损失。

这次非常感觉像大和证券试水性的建立了 Bitcoin 的敞口。

@ VIP,费率更低,福利更狠

BTC-1.63%

- 赞赏

- 点赞

- 评论

- 转发

- 分享

欧盟提议全面禁止与俄罗斯的所有加密货币交易,以防止规避制裁。

欧盟于 2026年2月6日 前后宣布的第 20 轮对俄罗斯制裁方案,该方案扩展了先前的金融限制措施。

根据欧盟官方文件和报道,这些措施基于 2025年7月 的先前行动,将 SWIFT 禁令扩展到对某些俄罗斯银行和第三方国家运营商的全面交易禁令,包括涉及规避制裁的加密资产提供商。

关键内容包括禁止欧盟运营商与列出的俄罗斯银行、金融机构以及相关的第三方国家实体(如吉尔吉斯斯坦、阿联酋或香港)进行交易。

全面禁止与俄罗斯数字卢布和俄罗斯加密资产服务提供商的交易,超出先前钱包余额上限,转而直接阻止交易。

扩展限制,向俄罗斯个人或实体提供加密钱包、账户或托管服务,包括禁止俄罗斯人拥有或控制此类服务提供商。

针对涉嫌帮助俄罗斯通过数字支付规避制裁的平台和公司,并引入大额转账的新报告要求

@ VIP,费率更低,福利更狠

欧盟于 2026年2月6日 前后宣布的第 20 轮对俄罗斯制裁方案,该方案扩展了先前的金融限制措施。

根据欧盟官方文件和报道,这些措施基于 2025年7月 的先前行动,将 SWIFT 禁令扩展到对某些俄罗斯银行和第三方国家运营商的全面交易禁令,包括涉及规避制裁的加密资产提供商。

关键内容包括禁止欧盟运营商与列出的俄罗斯银行、金融机构以及相关的第三方国家实体(如吉尔吉斯斯坦、阿联酋或香港)进行交易。

全面禁止与俄罗斯数字卢布和俄罗斯加密资产服务提供商的交易,超出先前钱包余额上限,转而直接阻止交易。

扩展限制,向俄罗斯个人或实体提供加密钱包、账户或托管服务,包括禁止俄罗斯人拥有或控制此类服务提供商。

针对涉嫌帮助俄罗斯通过数字支付规避制裁的平台和公司,并引入大额转账的新报告要求

@ VIP,费率更低,福利更狠

- 赞赏

- 点赞

- 评论

- 转发

- 分享

鉴于“美国债务可能让银行面临剧烈波动”的担忧,中国已指示银行开始抛售并限制购买美债。

这可能是中美关系走弱的信号开始,而这条信息正好是在日本选举结束后。

这可能是中美关系走弱的信号开始,而这条信息正好是在日本选举结束后。

- 赞赏

- 1

- 评论

- 转发

- 分享

一觉醒来不知道发生了什么,但这个价格可以,正在分批买入,越跌越买。买了再看。

- 赞赏

- 点赞

- 1

- 转发

- 分享

时间之外的往事 :

:

能不能多上上网,看看新闻,关注下局势在 Tether CEO Paolo Ardoino 接受彭博社采访的时候透露出 Tether 持有约 140 吨黄金,其中大部分是其自身储备,加上用于背书其黄金稳定币的黄金。并以每周约 1 到 2 吨的速度购买黄金,并计划在至少接下来的几个月继续这样做。持有实物黄金存储在瑞士的一个前核掩体中。Ardoino 不满足于仅仅购买黄金,他还希望 Tether 进行黄金交易。公司希望成为世界上最好的黄金交易平台来长期继续购买黄金并利用潜在的市场低效。Tether 对黄金的态度类似于央行。重视黄金的流动性,以及作为储备资产的地位,这种资产不是任何人或国家的债务。黄金逻辑上比任何国家货币更安全。新兴市场用户正是那些热爱黄金并用黄金保护自己免受本国政府货币贬值影响的人。说人话就是 Ardoino 认为黄金作为储备资产会比美债和美元更加重要,但这也意味着一个非常大的问题,Tether 购买黄金的钱是从哪里来的?Ardoino 表示这部分的资金是来自于 Tether 的利润,而不是用户的“本金”,但仍然会有部分的黄金成为 Tether 的储备资金,大概能有多少就要看最新一期 Tether 披露的数据了。@ VIP,费率更低,福利更狠

XAUT2.03%

- 赞赏

- 点赞

- 评论

- 转发

- 分享

提个问题,加密货币支付的发展在哪里?\n\n什么时候,什么场景,加密货币的支付是传统支付不能替代的。\n\n什么时候,什么场景,加密货币的支付能超过传统支付的天花板。

- 赞赏

- 点赞

- 评论

- 转发

- 分享

川普在达沃斯演讲中透露他关于美联储主席决定的想法时,川普说出了自己的担心:\n\n“问题是他们一旦上任就变了,真的会变。他们说了我想听的一切,然后一旦上任,他们的任期是六年,他们上任后,突然就说我们得把利率提高一点。\n\n我会跟他们说,先生,我们最好别谈这个。\n\n人们一旦有了职位改变。就会有点不忠,但他们得做他们认为对的事。”

- 赞赏

- 点赞

- 评论

- 转发

- 分享

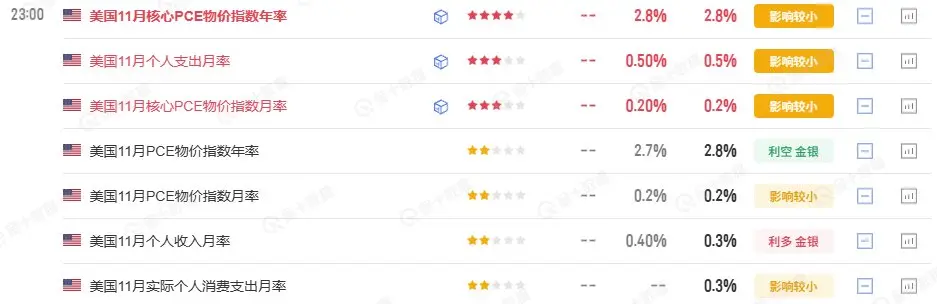

刚公布的美国11月通胀数据勉强还算可以,最重要的核心通胀在市场的预期之内,PCE年率虽然超过了市场预期,但并不算多,也算是正常,最重要的是这已经是11月的数据了,12月的核心PCE数据要到月底才公布了。这份数据也并不足以改变美联储在 1月 维持利率不动的结果。\n\n@ VIP,费率更低,福利更狠

- 赞赏

- 5

- 评论

- 转发

- 分享

😂不是说封了嘴撸以后 X 上的 AI 回复少了吗?我怎么完全看不到少了的迹象,仍然非常,非常的多,是因为还有很多 AI 不知道吗?

- 赞赏

- 点赞

- 评论

- 转发

- 分享

就在英伟达向香港输送第一批 H200 芯片的时候被海关阻止收货,本来预期要生产 100万 份的订单现在已经停止生产了。中美 AI 的战争开始表面化了。

- 赞赏

- 1

- 1

- 转发

- 分享

GateUser-09fd9666 :

:

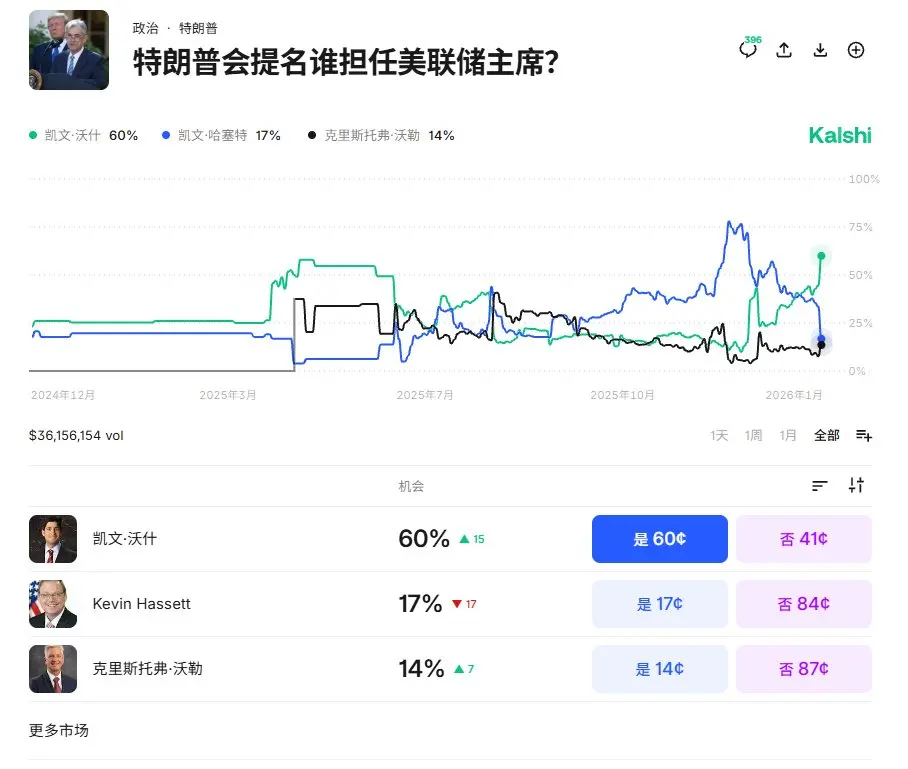

马年行大运,握住手中的筹码,持币待涨刚刚看了英文区很多小伙伴认为今天晚上出现的美股和 $BTC 的下跌是因为川普暗示不想让凯文·哈塞特接替鲍威尔成为新一任的美联储主席。

今天晚些的时候川普在发表演讲时说到“凯文·哈塞特 今天在电视上太棒了,其实我真想让你留在现在的位置,如果我把你调去美联储,但美联储的人不太爱说话,我就会失去你。这对我来说这是个严重的担忧。”

大概的意思就是川普很喜欢 凯文·哈塞特 在媒体的频频露面,认为 哈塞特 的讲话非常好,如果将 哈塞特 调任去了美联储,那么可能暂时没有能代替 哈塞特 的人选,讲话后预测市场对 哈塞特 能成为美联储主席的预测大幅下降,另一个候选人 凯文·沃什 的胜率上升到了 60% 。

而之所以这回导致风险市场的下跌,是因为 凯文·沃什 是前美联储理事,而且在任职期间非常的鹰派作风,这对于想要降息的川普来说可能并不是最佳的选择,当然这是市场的认为,而我个人认为川普不会傻到在捧一个鲍威尔出来,如果他愿意选择 凯文·沃什 ,大概率是和沃什已经有了对货币政策宽松的共识。

我是更觉得这种人会更加适合,在需要宽松的时候能听川普的指挥,一旦真的美国经济出现了衰退预期,他也不太会是直接的“马屁狗”,而且 凯文·沃什 在美联储的理事上干了五年,经验和人脉都更加充足。

@ VIP,费率更低,福利更狠

今天晚些的时候川普在发表演讲时说到“凯文·哈塞特 今天在电视上太棒了,其实我真想让你留在现在的位置,如果我把你调去美联储,但美联储的人不太爱说话,我就会失去你。这对我来说这是个严重的担忧。”

大概的意思就是川普很喜欢 凯文·哈塞特 在媒体的频频露面,认为 哈塞特 的讲话非常好,如果将 哈塞特 调任去了美联储,那么可能暂时没有能代替 哈塞特 的人选,讲话后预测市场对 哈塞特 能成为美联储主席的预测大幅下降,另一个候选人 凯文·沃什 的胜率上升到了 60% 。

而之所以这回导致风险市场的下跌,是因为 凯文·沃什 是前美联储理事,而且在任职期间非常的鹰派作风,这对于想要降息的川普来说可能并不是最佳的选择,当然这是市场的认为,而我个人认为川普不会傻到在捧一个鲍威尔出来,如果他愿意选择 凯文·沃什 ,大概率是和沃什已经有了对货币政策宽松的共识。

我是更觉得这种人会更加适合,在需要宽松的时候能听川普的指挥,一旦真的美国经济出现了衰退预期,他也不太会是直接的“马屁狗”,而且 凯文·沃什 在美联储的理事上干了五年,经验和人脉都更加充足。

@ VIP,费率更低,福利更狠

BTC-1.63%

- 赞赏

- 点赞

- 评论

- 转发

- 分享

内存和硬盘的上涨是否可以带动链上存储板块的爆发?

先说答案,从关联性来看,虽然不能说没有一毛钱的关系,但确实相关性可能不超过 1% 。

内存和硬盘的涨价主要是因为:

第一,这是一个典型的 AI 数据中心资本开支周期。

无论是 DRAM、HBM,还是企业级 HDD,本质上都服务于算力基础设施的扩张。AI 训练和推理并不只是吃显存,而是同时需要计算、内存、存储、电力和网络,这是一个完整的体系,而不是单一需求。

第二,需求是真实的,而不是概念性的。

数据中心需要的是高频、稳定、可预测的读写性能,以及极低的单位存储成本,内存和硬盘涨价,反映的是真实订单、真实采购、真实交付周期的变化,而不是情绪或预期。

第三,供给端是收缩,但并不短缺。

无论是内存还是 HDD,本轮价格上行都有一个共同特征, 厂商在经历过上一轮长期价格战后,选择控产量,提高售价,以及更多面向高端化和企业化,优先保证现金流和毛利率。这意味着价格对需求变化的敏感度被放大。

而链上存储,则完全是相反的。

第一,链上存储不服务于算力体系,而服务于共识体系。

AI 数据是需要大量真实的算力,而不是共识。把大规模数据用共识来形容本身在工程和经济上都是错误解。

第二,链上存储解决的是可信性问题,不是规模问题。

现实世界 99% 的存储需求,并不需要全网复制、不可删除和去中心化仲裁,它们需要的是便宜、稳定、可控、可追责。

先说答案,从关联性来看,虽然不能说没有一毛钱的关系,但确实相关性可能不超过 1% 。

内存和硬盘的涨价主要是因为:

第一,这是一个典型的 AI 数据中心资本开支周期。

无论是 DRAM、HBM,还是企业级 HDD,本质上都服务于算力基础设施的扩张。AI 训练和推理并不只是吃显存,而是同时需要计算、内存、存储、电力和网络,这是一个完整的体系,而不是单一需求。

第二,需求是真实的,而不是概念性的。

数据中心需要的是高频、稳定、可预测的读写性能,以及极低的单位存储成本,内存和硬盘涨价,反映的是真实订单、真实采购、真实交付周期的变化,而不是情绪或预期。

第三,供给端是收缩,但并不短缺。

无论是内存还是 HDD,本轮价格上行都有一个共同特征, 厂商在经历过上一轮长期价格战后,选择控产量,提高售价,以及更多面向高端化和企业化,优先保证现金流和毛利率。这意味着价格对需求变化的敏感度被放大。

而链上存储,则完全是相反的。

第一,链上存储不服务于算力体系,而服务于共识体系。

AI 数据是需要大量真实的算力,而不是共识。把大规模数据用共识来形容本身在工程和经济上都是错误解。

第二,链上存储解决的是可信性问题,不是规模问题。

现实世界 99% 的存储需求,并不需要全网复制、不可删除和去中心化仲裁,它们需要的是便宜、稳定、可控、可追责。

- 赞赏

- 点赞

- 评论

- 转发

- 分享

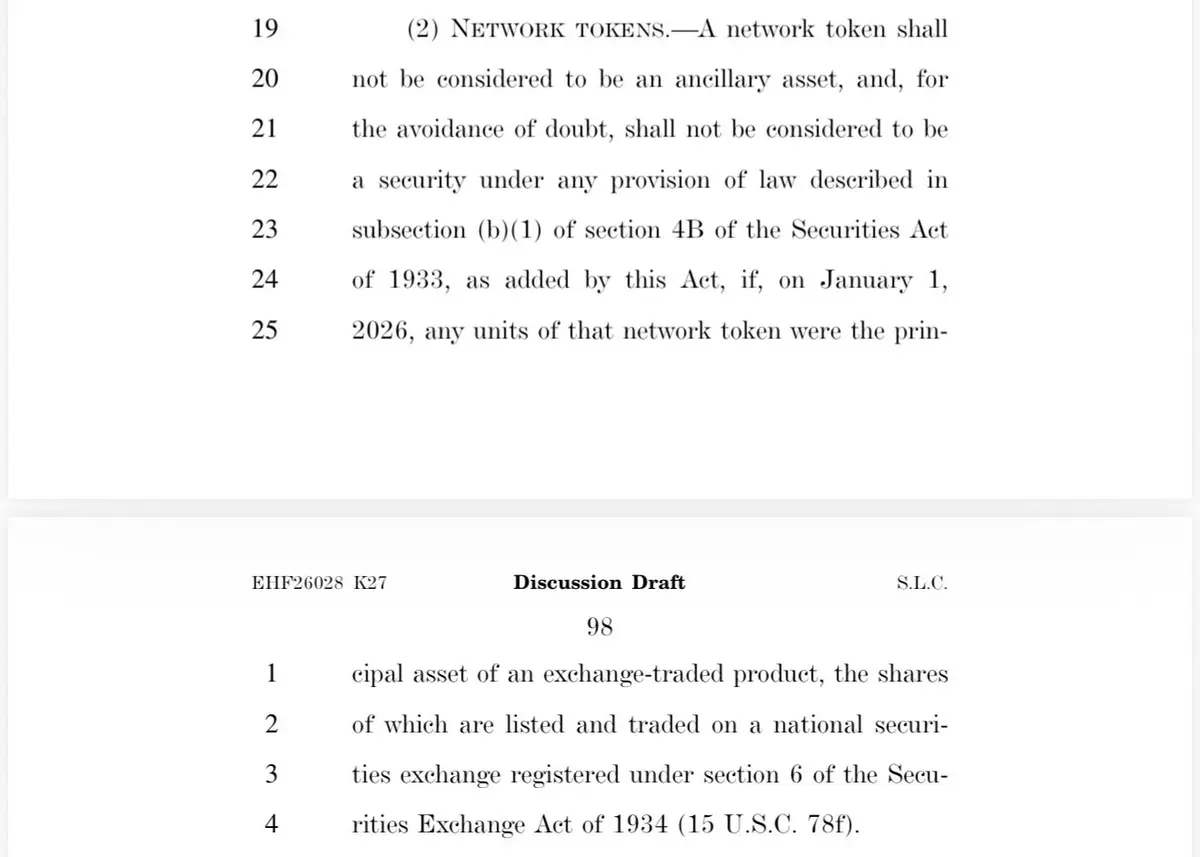

参议院银行委员会市场结构法案的草案中有一条信息很重要,明确某一类“网络代币(Network Token)在特定条件下不被视为证券。

如果某个网络代币在 2026年1月1日时,已经作为某个合规交易所交易产品(如 ETF、ETP)的“主要资产”,那么该网络代币在法律上将被明确排除在“证券”定义之外。

解读:这里主要指的就是已经成功上线的现货 ETF ,在 2026年1月1日前,已经成功上线的 ETF 包括了 $BTC $ETH $SOL 以上三种资产甚至还有 CME 的期货。

然后还包括了 $DOGE $HBAR $LTC 和 $XRP (不知道我有没有遗漏)

如果该法案通过,就说明这些加密货币已经不在算是证券。

@ VIP,费率更低,福利更狠

如果某个网络代币在 2026年1月1日时,已经作为某个合规交易所交易产品(如 ETF、ETP)的“主要资产”,那么该网络代币在法律上将被明确排除在“证券”定义之外。

解读:这里主要指的就是已经成功上线的现货 ETF ,在 2026年1月1日前,已经成功上线的 ETF 包括了 $BTC $ETH $SOL 以上三种资产甚至还有 CME 的期货。

然后还包括了 $DOGE $HBAR $LTC 和 $XRP (不知道我有没有遗漏)

如果该法案通过,就说明这些加密货币已经不在算是证券。

@ VIP,费率更低,福利更狠

- 赞赏

- 3

- 1

- 转发

- 分享

GateUser-87adec4b :

:

感谢您的宝贵信息热门话题

查看更多20.99万 热度

1.27万 热度

4.56万 热度

8.58万 热度

85.01万 热度

置顶

福利加码,Gate 广场明星带单交易员二期招募开启!

入驻发帖 · 瓜分 $20,000 月度奖池 & 千万级流量扶持!

如何参与:

1️⃣ 报名成为跟单交易员:https://www.gate.com/copytrading/lead-trader-registration/futures

2️⃣ 报名活动:https://www.gate.com/questionnaire/7355

3️⃣ 入驻 Gate 广场,持续发布交易相关原创内容

丰厚奖励等你拿:

首帖福利:首发优质内容即得 $30 跟单体验金

双周内容激励:每双周瓜分 $500U 内容奖池

排行榜奖励:Top 10 交易员额外瓜分 $20,000 登榜奖池

流量扶持:精选帖推流、首页推荐、周度明星交易员曝光

活动时间:2026 年 2 月 12 日 18:00 – 2 月 24 日 24:00(UTC+8)

详情:https://www.gate.com/announcements/article/49849Gate 广场内容挖矿奖励继续升级!无论您是创作者还是用户,挖矿新人还是头部作者都能赢取好礼获得大奖。现在就进入广场探索吧!

创作者享受最高60%创作返佣

创作者奖励加码1500USDT:更多新人作者能瓜分奖池!

观众点击交易组件交易赢大礼!最高50GT等新春壕礼等你拿!

详情:https://www.gate.com/announcements/article/49802🏮 新年快乐,马上发财!Gate 广场 $50,000 红包雨狂降!

发帖即领,手慢无 👉 https://www.gate.com/campaigns/4044

🧨 三重惊喜,陪您红火过新年:

1️⃣ $50,000 红包雨:发帖即领,新用户 100% 中奖,单帖最高 28 GT

2️⃣ 马年锦鲤:带 #我在Gate广场过新年 发帖,抽 1 人送 50 GT + 新春礼盒

3️⃣ 创作者榜单赛:赢国米球衣、Red Bull 联名夹克、VIP 露营套装等豪礼

📅 2/9 17:00 – 2/23 24:00(UTC+8)

请将 App 更新至 8.8.0+ 版本参与

详情:https://www.gate.com/announcements/article/49773Gate 广场“新星计划”正式上线!

开启加密创作之旅,瓜分月度 $10,000 奖励!

参与资格:从未在 Gate 广场发帖,或连续 7 天未发帖的创作者

立即报名:https://www.gate.com/questionnaire/7396

您将获得:

💰 1,000 USDT 月度创作奖池 + 首帖 $50 仓位体验券

🔥 半月度「爆款王」:Gate 50U 精美周边

⭐ 月度前 10「新星英雄榜」+ 粉丝达标榜单 + 精选帖曝光扶持

加入 Gate 广场,赢奖励 ,拿流量,建立个人影响力!

详情:https://www.gate.com/announcements/article/49672