分享币圈内容,享内容挖矿收益

placeholder

Shardy

你应该参加MagicBlock的预售吗?

MagicBlock于1月15日宣布启动$BLOCK token预售。预售计划将于2025年2月5日开始,分为两个主要阶段,持续3天:

1. 阶段 - WL优先 (前24小时):白名单地址有24小时的参与时间。要参加此阶段,必须是MagicBlock社区的核心成员或在链上与MagicBlock应用互动的地址。

2. 阶段 - 一般 (后续48小时):白名单被列入后24小时内,仍有配额的任何人都可以参与。

MagicBlock为参与者提供两种购买方式。

选项1 - 先到先得(FCFS):Token的100%将在TGE (总有效期)时开放。Token价格由反映100百万至2亿美元FDV的远期合约曲线确定,价格在0.01至0.02美元之间。

选项2 - 配额申请:以等同于1亿美元市值的固定价格申请配额。在(预售结束后,有一周的审查期决定是否分配配额,如果参与者选择此方式,最终销售后将被禁止访问系统1年。

关于TGE时间表,预计将在2026年第一季度末或第二季度初完成。具体时间取决于项目的开发和审查进展。因此,是否参加MagicBlock的预售是一个非常重要的问题。

如果问我,由于100百万到2亿美元的估值已经不再具有吸引力,我不会参与。

看看最新的预售提案⤵️

Solana上的领先AMM公司Humidifi的TGE仅超过1亿美元,

Infinex

MagicBlock于1月15日宣布启动$BLOCK token预售。预售计划将于2025年2月5日开始,分为两个主要阶段,持续3天:

1. 阶段 - WL优先 (前24小时):白名单地址有24小时的参与时间。要参加此阶段,必须是MagicBlock社区的核心成员或在链上与MagicBlock应用互动的地址。

2. 阶段 - 一般 (后续48小时):白名单被列入后24小时内,仍有配额的任何人都可以参与。

MagicBlock为参与者提供两种购买方式。

选项1 - 先到先得(FCFS):Token的100%将在TGE (总有效期)时开放。Token价格由反映100百万至2亿美元FDV的远期合约曲线确定,价格在0.01至0.02美元之间。

选项2 - 配额申请:以等同于1亿美元市值的固定价格申请配额。在(预售结束后,有一周的审查期决定是否分配配额,如果参与者选择此方式,最终销售后将被禁止访问系统1年。

关于TGE时间表,预计将在2026年第一季度末或第二季度初完成。具体时间取决于项目的开发和审查进展。因此,是否参加MagicBlock的预售是一个非常重要的问题。

如果问我,由于100百万到2亿美元的估值已经不再具有吸引力,我不会参与。

看看最新的预售提案⤵️

Solana上的领先AMM公司Humidifi的TGE仅超过1亿美元,

Infinex

SOL-3.67%

- 赞赏

- 点赞

- 评论

- 转发

- 分享

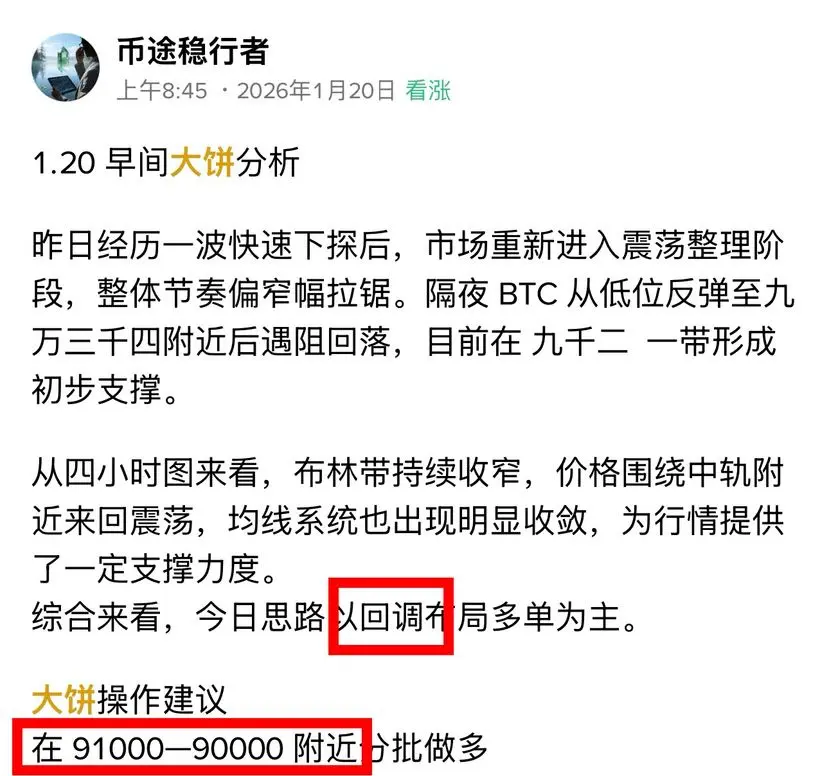

你亲爱的多头和极端狂热者们并没有帮你在126k卖出

他们说每次反弹都充满希望

他们给你无效的卖出点在74k以下

Vector prime 承受了打击,但带领羊群安全撤离

称呼大部分的长线拉升

#比特币

他们说每次反弹都充满希望

他们给你无效的卖出点在74k以下

Vector prime 承受了打击,但带领羊群安全撤离

称呼大部分的长线拉升

#比特币

BTC-2.54%

- 赞赏

- 点赞

- 评论

- 转发

- 分享

暴富币

暴富币

创建人@金马币发起共识者

上市进度

4.87%

市值:

$4422

创建我的代币

目前的价格(3107美元)

📋 方案参考:3080-3100 区间低吸(多单)

1. 第一笔:现价附近轻仓试错(约 3107)

- 操作:限价买入 / 市价买入

- 数量:3% 仓位(300USDT 价值)

- 止损设置:设置 3060 为止损价(一旦跌破3080强支撑,无条件离场)

- 目的:防止价格直接反弹踏空。

2. 第二笔:关键支撑位补仓(3090-3100)

- 操作:设置 限价买单

- 价格:3095

- 数量:4% 仓位(400USDT 价值)

- 目的:摊平成本,降低风险。

3. 第三笔:极限防守位(3080-3085)

- 操作:设置 限价买单

- 价格:3082

- 数量:3% 仓位(300USDT 价值)

- 目的:博反弹的最后防线。

🎯 止盈与止损设置(非常重要)

1. 止损(Stop Loss):

- 统一设置止损价为 3060。

- 逻辑 :3080是强支撑,跌破说明空头极强,必须跑路,不能扛单。

2. 止盈(Take Profit):

- TP1(减仓):设置 3150。

- 动作 :到了3150,卖出 50% 的仓位,把本金和利润拿回来一部分,剩下的博取更大收益。

- TP2(清仓):设置 3180。

- 动作 :到了3180,全部卖出离场。

#感谢关注︱互动︱评论︱转发

📋 方案参考:3080-3100 区间低吸(多单)

1. 第一笔:现价附近轻仓试错(约 3107)

- 操作:限价买入 / 市价买入

- 数量:3% 仓位(300USDT 价值)

- 止损设置:设置 3060 为止损价(一旦跌破3080强支撑,无条件离场)

- 目的:防止价格直接反弹踏空。

2. 第二笔:关键支撑位补仓(3090-3100)

- 操作:设置 限价买单

- 价格:3095

- 数量:4% 仓位(400USDT 价值)

- 目的:摊平成本,降低风险。

3. 第三笔:极限防守位(3080-3085)

- 操作:设置 限价买单

- 价格:3082

- 数量:3% 仓位(300USDT 价值)

- 目的:博反弹的最后防线。

🎯 止盈与止损设置(非常重要)

1. 止损(Stop Loss):

- 统一设置止损价为 3060。

- 逻辑 :3080是强支撑,跌破说明空头极强,必须跑路,不能扛单。

2. 止盈(Take Profit):

- TP1(减仓):设置 3150。

- 动作 :到了3150,卖出 50% 的仓位,把本金和利润拿回来一部分,剩下的博取更大收益。

- TP2(清仓):设置 3180。

- 动作 :到了3180,全部卖出离场。

#感谢关注︱互动︱评论︱转发

【当前用户分享了他的交易卡片,若想了解更多优质交易信息,请到App端查看】

- 赞赏

- 点赞

- 评论

- 转发

- 分享

- 赞赏

- 点赞

- 评论

- 转发

- 分享

Gate TradFi 黄金幸运包来了!每日交易赢取1,152克黄金

在TradFi交易,每10分钟即可获得1次抽奖。

完成单笔交易≥100 USDT,即解锁连续5次抽奖机会。

允许多次参与,重复中奖可能!

⏰ 活动时间:2026年1月20日07:40 (UTC) – 2026年1月30日08:20 (UTC)

🎁 每次抽奖1克黄金 (当前价格约$150)。黄金价格创下新高——你的奖励可能持续升值!

👉 立即加入:https://www.gate.com/zh/campaigns/4-gold-lucky-draw

查看原文在TradFi交易,每10分钟即可获得1次抽奖。

完成单笔交易≥100 USDT,即解锁连续5次抽奖机会。

允许多次参与,重复中奖可能!

⏰ 活动时间:2026年1月20日07:40 (UTC) – 2026年1月30日08:20 (UTC)

🎁 每次抽奖1克黄金 (当前价格约$150)。黄金价格创下新高——你的奖励可能持续升值!

👉 立即加入:https://www.gate.com/zh/campaigns/4-gold-lucky-draw

- 赞赏

- 2

- 2

- 转发

- 分享

speak silent :

:

2026年GOGOGO 👊查看更多

黄金刚刚创下了新的历史最高点。

查看原文

- 赞赏

- 点赞

- 评论

- 转发

- 分享

- 赞赏

- 点赞

- 评论

- 转发

- 分享

🔴 黄金价格持续上涨,突破每盎司4000欧元。

查看原文- 赞赏

- 点赞

- 评论

- 转发

- 分享

逍遥仙宗

逍遥仙宗

创建人@GateUser-3145cf0e

上市进度

0.08%

市值:

$3510.45

创建我的代币

新的一天不要求你完美无缺。它只是邀请你出现。

无论昨天发生了什么,今天都提供了另一个以意图、优雅和一点希望前进的机会。

放慢脚步,深呼吸,记住,即使安静,进步也算数。祝你度过一个平静、专注且有意义的一天。

早安,国王们。🤞🤞🤞

查看原文无论昨天发生了什么,今天都提供了另一个以意图、优雅和一点希望前进的机会。

放慢脚步,深呼吸,记住,即使安静,进步也算数。祝你度过一个平静、专注且有意义的一天。

早安,国王们。🤞🤞🤞

- 赞赏

- 点赞

- 评论

- 转发

- 分享

我曾经查看图表,看看我赚了多少钱;现在我查看它们,看看我是否还存在。

查看原文

- 赞赏

- 点赞

- 评论

- 转发

- 分享

#欧美关税风波冲击市场 先明确核心结论:GAT(图注意力网络)是GNN的重要分支,核心是利用注意力机制动态分配邻居权重,解决GCN等固定权重的局限,兼顾自适应、可并行与可解释,适合异质/动态图与节点分类等任务,但存在计算与过拟合风险。以下从原理、优劣势、应用与实践要点展开。

一、核心原理

- 节点学会“更关注哪些邻居”,用注意力权重加权聚合邻居信息,获得更精准的节点表示。

- 计算流程:

1. 节点特征通过权重矩阵投影到新空间进行线性变换。

2. 使用自注意力计算邻居间相关分数,并通过softmax归一化。

3. 根据注意力权重聚合邻居特征,同时保留节点自身的信息。

4. 使用多头增强技术,中间层拼接多头输出扩展维度,输出层取均值提升稳定性。

二、核心优势

- 自适应加权:无需依赖图结构,数据驱动学权重,更贴合复杂关系。

- 高效并行:邻居权重可独立计算,不依赖全局邻接矩阵,适配大规模与动态图。

- 可解释性强:注意力权重可视化,便于分析关键连接与决策依据。

- 归纳能力好:能够处理训练时未见过的节点与结构,泛化性更优。

三、局限与风险

- 计算成本高:随着邻居数量增加而上升,处理超大规模图需要采样优化。

- 过拟合风险:多头注意力参数多,在小样本上容易学习到噪声模式。

- 边信息利用弱:原生GAT较少直接建模边特征,适应异质图需要扩展(如HAN)。

- 注意力偏置

一、核心原理

- 节点学会“更关注哪些邻居”,用注意力权重加权聚合邻居信息,获得更精准的节点表示。

- 计算流程:

1. 节点特征通过权重矩阵投影到新空间进行线性变换。

2. 使用自注意力计算邻居间相关分数,并通过softmax归一化。

3. 根据注意力权重聚合邻居特征,同时保留节点自身的信息。

4. 使用多头增强技术,中间层拼接多头输出扩展维度,输出层取均值提升稳定性。

二、核心优势

- 自适应加权:无需依赖图结构,数据驱动学权重,更贴合复杂关系。

- 高效并行:邻居权重可独立计算,不依赖全局邻接矩阵,适配大规模与动态图。

- 可解释性强:注意力权重可视化,便于分析关键连接与决策依据。

- 归纳能力好:能够处理训练时未见过的节点与结构,泛化性更优。

三、局限与风险

- 计算成本高:随着邻居数量增加而上升,处理超大规模图需要采样优化。

- 过拟合风险:多头注意力参数多,在小样本上容易学习到噪声模式。

- 边信息利用弱:原生GAT较少直接建模边特征,适应异质图需要扩展(如HAN)。

- 注意力偏置

- 赞赏

- 点赞

- 评论

- 转发

- 分享

Maverick Capital 即将到来。在行业投资中追求数学般的精准!

查看原文

- 赞赏

- 点赞

- 评论

- 转发

- 分享

#LTC 在长期支撑位上摇摇欲坠,但在这个长期周线图上出现了微弱的隐藏看涨背离,显示可能会反弹的迹象。

持币者可能会继续持有。

新多头仓位是合理的,止损设在以下位置,如果支撑位被突破,也可以考虑做空。

持币者可能会继续持有。

新多头仓位是合理的,止损设在以下位置,如果支撑位被突破,也可以考虑做空。

LTC-2.64%

- 赞赏

- 点赞

- 评论

- 转发

- 分享

继续挑战任务第2️⃣🈷️第2天

- 赞赏

- 点赞

- 评论

- 转发

- 分享

加载更多

加入 4000万 人汇聚的头部社区

⚡️ 与 4000万 人一起参与加密货币热潮讨论

💬 与喜爱的头部博主互动

👍 查看感兴趣的内容

热门话题

查看更多146 热度

2.97万 热度

4.75万 热度

9147 热度

7580 热度

快讯

查看更多置顶

Gate 广场创作者新春激励正式开启,发帖解锁 $60,000 豪华奖池

如何参与:

报名活动表单:https://www.gate.com/questionnaire/7315

使用广场任意发帖小工具,搭配文字发布内容即可

丰厚奖励一览:

发帖即可可瓜分 $25,000 奖池

10 位幸运用户:获得 1 GT + Gate 鸭舌帽

Top 发帖奖励:发帖与互动越多,排名越高,赢取 Gate 新年周边、Gate 双肩包等好礼

新手专属福利:首帖即得 $50 奖励,继续发帖还能瓜分 $10,000 新手奖池

活动时间:2026 年 1 月 8 日 16:00 – 1 月 26 日 24:00(UTC+8)

详情:https://www.gate.com/announcements/article/49112来Gate广场发帖分享你的GateAI 使用感受,赢丰厚奖励!

🎁 精选10 位幸运用户,每人奖励 $10 仓位体验券!

📌 如何参与?

1️⃣ 关注 Gate 广场_Official

2️⃣ 在广场发帖,带上话题 #我的GateAI使用体验,帖文需附上使用GateAI页面的截图

3️⃣ 创作内容表达使用感受、建议等不限

3️⃣ 帖子内容 不少于 30 字,且仅带本活动话题标签

GateAI上线详情:https://www.gate.com/announcements/article/49070

活动截止时间:2026/01/15 18:00(UTC+8)

快来广场分享你的 GateAI 使用感受吧 🚀每天看行情、刷大佬观点,却不发声?你的观点可能比你想的更有价值!

广场新人 & 回归福利进行中!首次发帖或久违回归,直接送你奖励!

每月 $20,000 奖金等你瓜分!

在广场带 #我在广场发首帖 发布首帖或回归帖即可领取 $50 仓位体验券

月度发帖王和互动王还将各获额外 50U 奖励

你的加密观点可能启发无数人,开始创作之旅吧!

👉️ https://www.gate.com/postGate 广场「创作者认证激励计划」优质创作者持续招募中!

立即加入,发布优质内容,参与活动即可瓜分月度 $10,000+ 创作奖励!

认证申请步骤:

1️⃣ 打开 App 首页底部【广场】 → 点击右上角头像进入个人主页

2️⃣ 点击头像右下角【申请认证】,提交申请等待审核

立即报名:https://www.gate.com/questionnaire/7159

豪华代币奖池、Gate 精美周边、流量曝光等超 $10,000 丰厚奖励等你拿!

活动详情:https://www.gate.com/announcements/article/47889Gate 2025 年终盛典|广场 TOP50 榜单正式公布!

冲榜关键期已开启,看直播、发帖即可获得助力值

30 助力值 = 1 票,快来为你喜爱的创作者投票

👉 https://www.gate.com/activities/community-vote-2025

iPhone 17 Pro Max、京东 E 卡、小米手环、Gate 独家周边、仓位体验券等你赢!

内容达人也欢迎积极发帖拉票,冲榜赢取荣誉与奖励!

投票截止:1 月 20 日 10:00(UTC+8)

详情:https://www.gate.com/announcements/article/48693