Інфраструктура криптовалют ще не є ідеальною

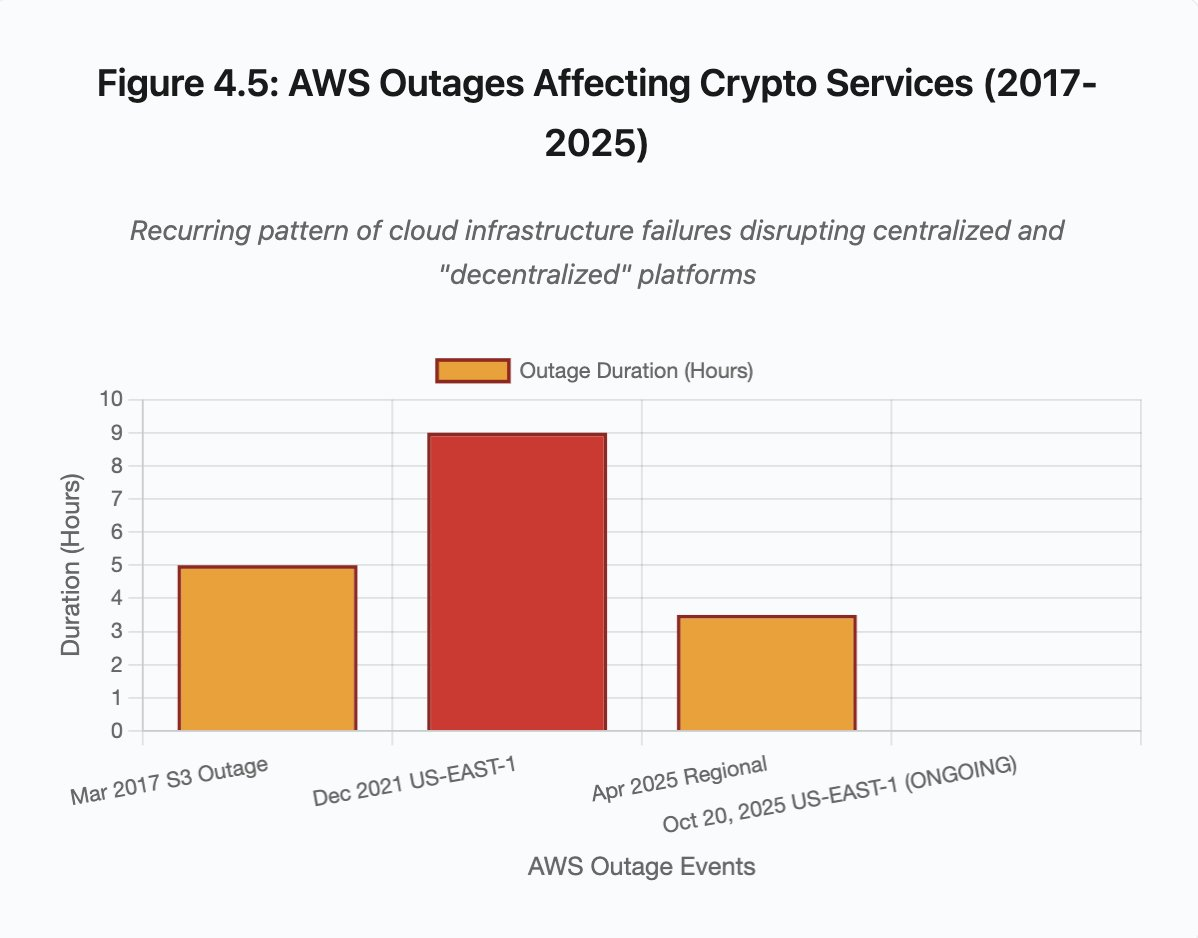

На момент публікації цього матеріалу Amazon Web Services знову переживає масштабний збій, що впливає на криптовалютну інфраструктуру. Починаючи приблизно з 08:00 за британським часом сьогодні, проблеми AWS у регіоні US-EAST-1 (дата-центри Північної Вірджинії) призвели до недоступності Coinbase і десятків інших провідних криптоплатформ, серед яких Robinhood, Infura, Base та Solana.

AWS офіційно підтвердила «збільшення частоти помилок», що торкнулися Amazon DynamoDB та EC2 — ключових сервісів баз даних і обчислень, від яких залежить діяльність тисяч компаній. Цей збій у реальному часі безпосередньо підтверджує головний висновок статті: залежність криптоінфраструктури від централізованих хмарних провайдерів створює системні уразливості, які повторюються під час пікових навантажень.

Часовий контекст показовий. Всього через десять днів після каскаду ліквідацій на $19,3 млрд, що виявив проблеми на рівні біржової інфраструктури, нинішній збій AWS демонструє: проблема стосується не лише окремих платформ, а й фундаментального шару хмарної інфраструктури. Коли AWS виходить з ладу, наслідки охоплюють централізовані біржі, «децентралізовані» платформи з централізованими залежностями та численні сервіси одночасно.

Це не поодинокий інцидент, а стійка тенденція. Далі наведено аналіз подібних збоїв AWS у квітні 2025, грудні 2021 та березні 2017 років, кожного разу призупиняючи роботу ключових криптосервісів. Питання полягає не в «чи», а в «коли» і «що стане тригером» наступного інфраструктурного збою.

Каскад ліквідацій 10–11 жовтня 2025 року: кейс-стаді

Події 10–11 жовтня 2025 року — це показовий приклад інфраструктурного збою. О 20:00 (UTC) масштабна геополітична заява спровокувала масові розпродажі. Протягом години відбулося ліквідацій на $6 млрд. На момент відкриття азійських ринків зникли $19,3 млрд у кредитних позиціях 1,6 млн трейдерських акаунтів.

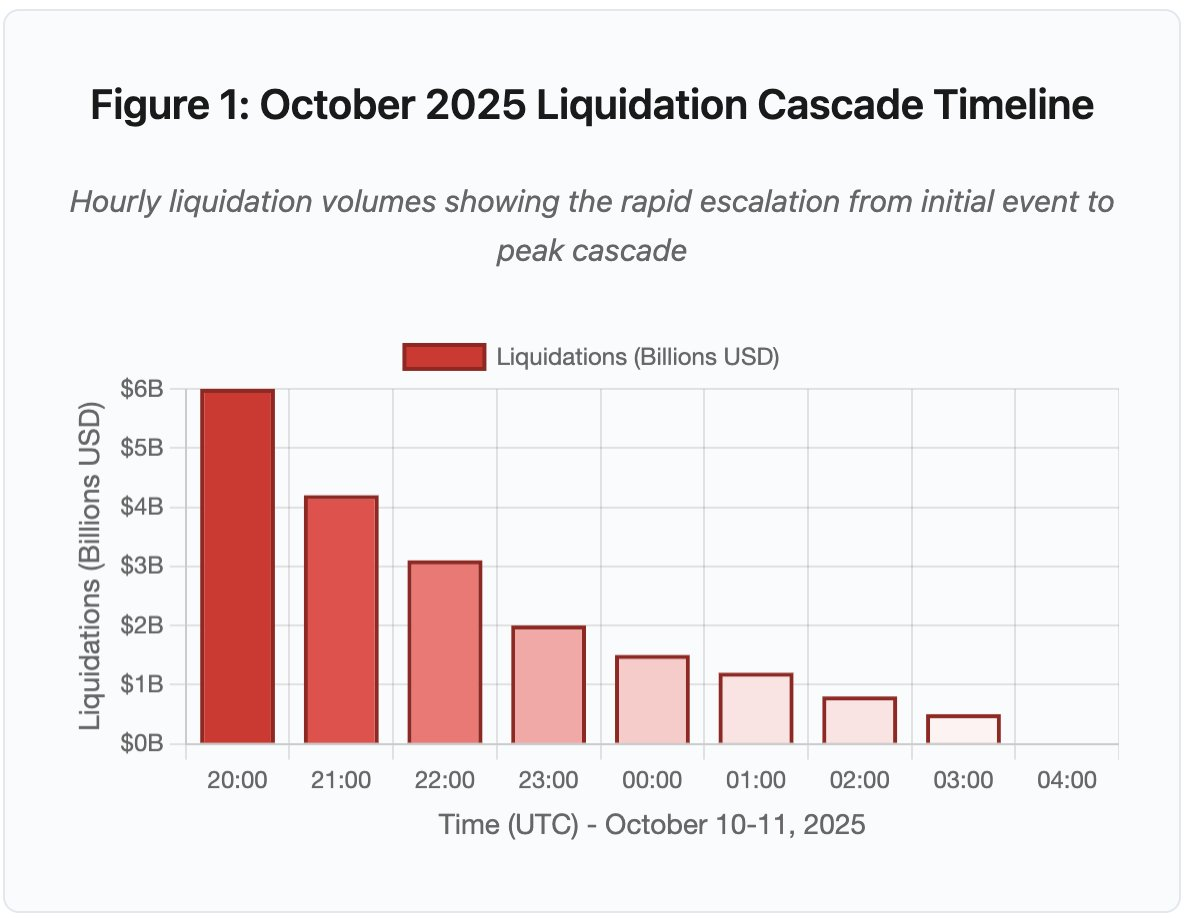

Рисунок 1: Хронологія каскаду ліквідацій жовтня 2025

Інтерактивний графік демонструє драматичний розвиток ліквідацій по годинах. За першу годину зникло $6 млрд, а наступна стала ще більш напруженою, коли каскад прискорився. Ключові моменти:

- 20:00–21:00: Початковий шок — $6 млрд ліквідовано (червона зона)

- 21:00–22:00: Пік каскаду — $4,2 млрд під час старту обмежень API

- 22:00–04:00: Тривала деградація — $9,1 млрд на малоліквідних ринках

- Критичні точки: обмеження API, відхід маркет-мейкерів, звуження книги ордерів

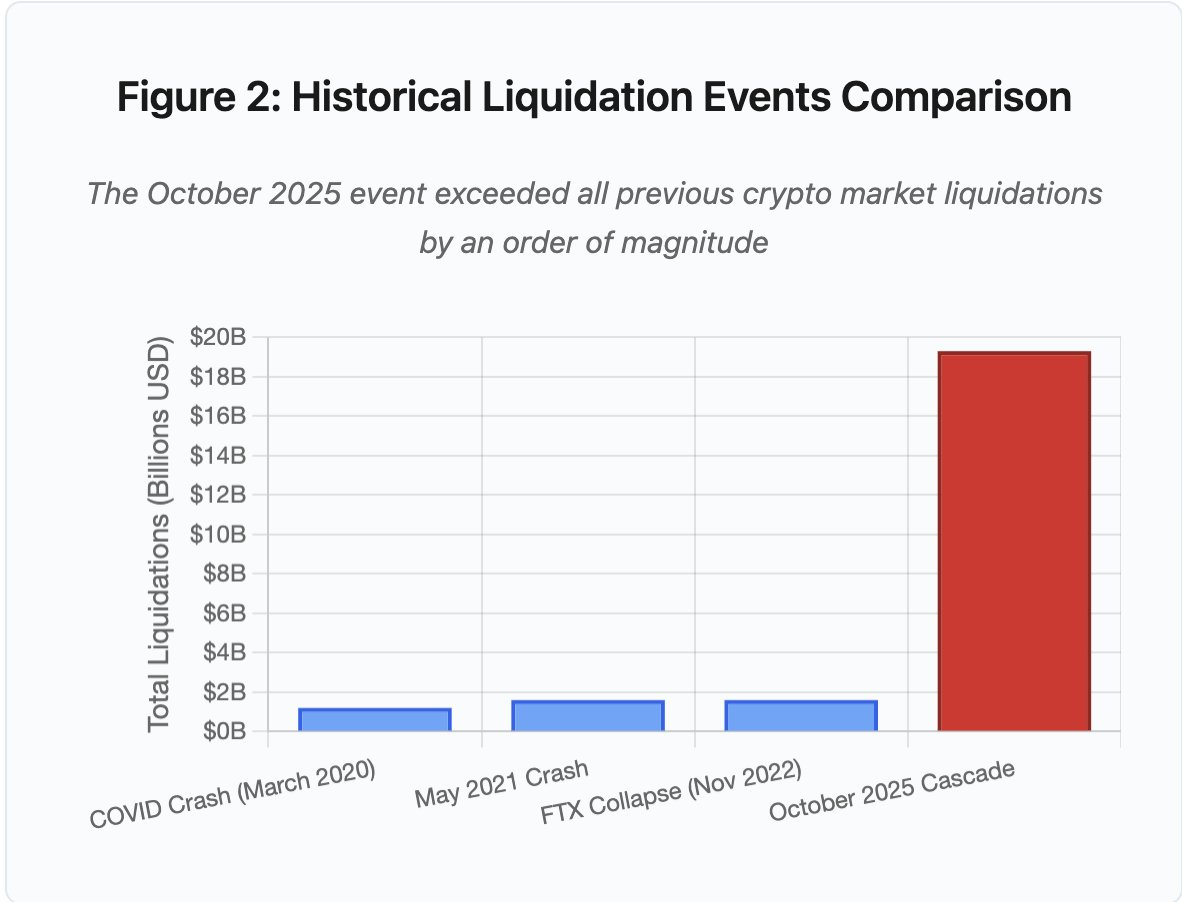

Масштаби події перевищують усі попередні випадки на крипторинку щонайменше на порядок. Історичне порівняння ілюструє характер «ступінчастого переходу»:

Рисунок 2: Порівняння історичних каскадів ліквідацій

Графік у вигляді стовпців чітко показує унікальність жовтня 2025 року:

- Березень 2020 (COVID): $1,2 млрд

- Травень 2021 (Crash): $1,6 млрд

- Листопад 2022 (FTX): $1,6 млрд

- Жовтень 2025: $19,3 млрд ⚠️ у 16 разів більше за попередній рекорд

Втім, цифри ліквідацій — лише частина картини. Важливіше — механізм: як зовнішні ринкові події спровокували такий тип збою? Відповідь розкриває системні слабкі місця централізованої біржової інфраструктури та дизайну блокчейн-протоколів.

Збої поза блокчейном: архітектура централізованих бірж

Перевантаження інфраструктури та обмеження швидкості

API бірж впроваджують ліміти запитів для запобігання зловживанням і контролю навантаження. В штатному режимі це дозволяє легітимну торгівлю, блокуючи атаки. Однак при екстремальній волатильності, коли тисячі трейдерів одночасно змінюють позиції, ці ліміти стають вузьким місцем.

CEX обмежує повідомлення про ліквідації до одного ордера за секунду, навіть якщо обробляє тисячі ордерів за секунду. У жовтні це створило непрозорість: користувачі не могли оцінити актуальний масштаб каскаду. Сторонні інструменти фіксували сотні ліквідацій за хвилину, офіційні дані — значно менше.

Обмеження API заблокували можливість трейдерів змінювати позиції у критичну першу годину. Підключення завершувалися тайм-аутом, подання ордерів не проходило, стоп-лос ордери не виконувались, запити позицій повертали застарілі дані. Це інфраструктурне вузьке місце перетворило ринкову подію на операційну кризу.

Традиційні біржі масштабують інфраструктуру для стандартного навантаження плюс запас міцності. Проте штатне навантаження суттєво відрізняється від стресового. Середньодобовий обсяг торгів не передбачає пікові вимоги. Під час каскадів обсяг транзакцій може зрости у 100 разів і більше, а запитів до позицій — у 1 000 разів, коли кожен користувач перевіряє акаунт.

Рисунок 4.5: Збої AWS, що впливають на криптосервіси

Автоматичне масштабування хмарної інфраструктури допомагає, але не реагує миттєво. Розгортання додаткових реплік бази даних та екземплярів API gateway займає хвилини. За цей час маржинальні системи оцінюють позиції за спотвореними цінами з перевантажених книг ордерів.

Маніпуляція ораклами та цінові уразливості

Під час жовтневого каскаду виявилася критична особливість маржинальних систем: деякі біржі розраховували забезпечення на основі внутрішніх спотових цін, а не зовнішніх ораклів. У нормальних умовах арбітраж підтримує цінову відповідність між майданчиками, але під навантаженням ця зв’язка руйнується.

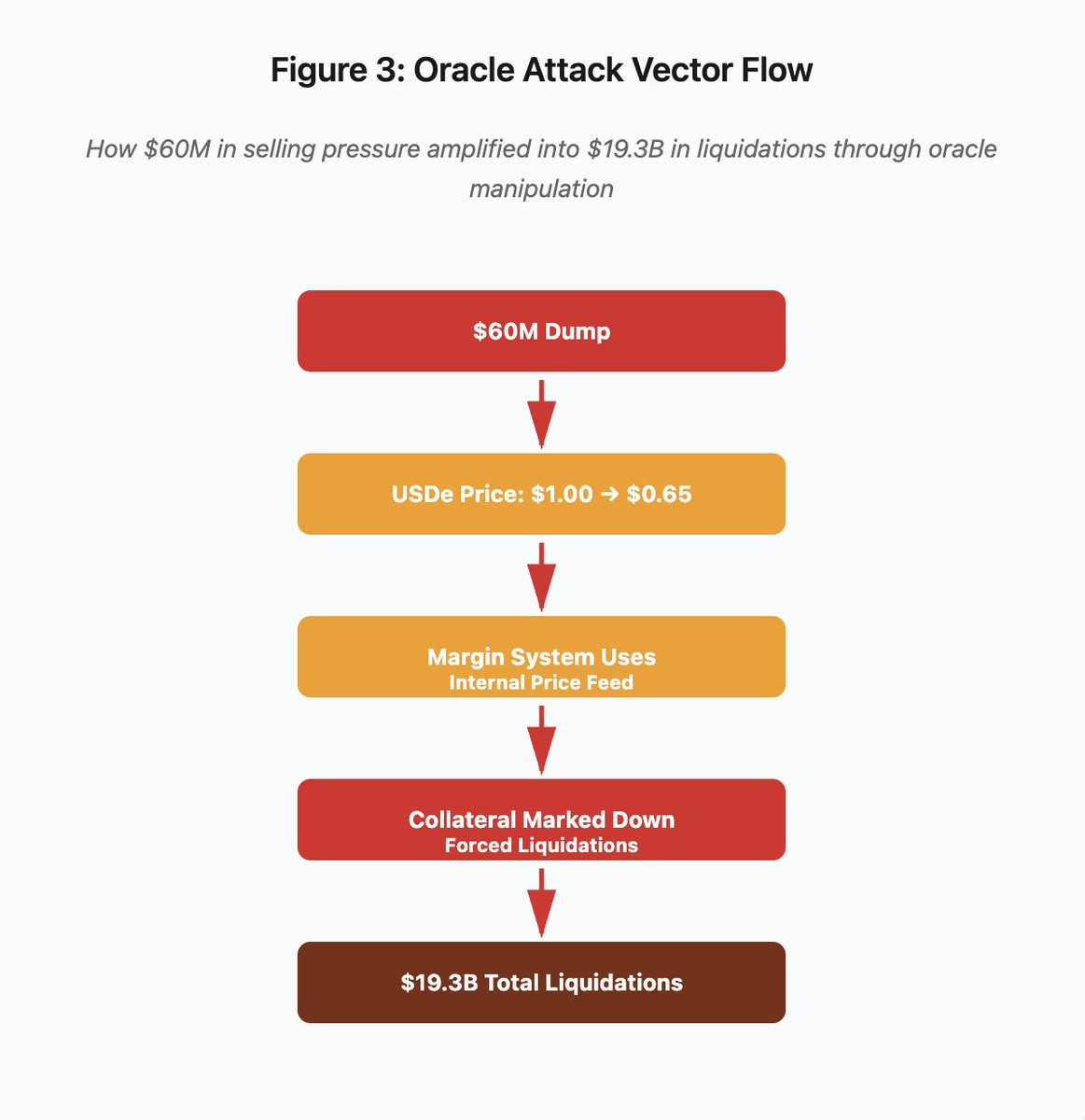

Рисунок 3: Схема маніпуляції ораклом

Схема демонструє атаку у п’яти етапах:

- Початковий дамп: $60 млн тиску продажу на USDe

- Маніпуляція ціною: USDe падає з $1,00 до $0,65 на одній біржі

- Збій оракла: маржинальна система використовує спотворений внутрішній ціновий фід

- Триггер каскаду: забезпечення знижується, починаються примусові ліквідації

- Посилення: $19,3 млрд загальних ліквідацій (322-кратне посилення)

Атака використала спотові ціни Binance для забезпечення синтетичних активів. Коли атакувальник продав $60 млн USDe у малоліквідних книгах ордерів, ціна впала з $1,00 до $0,65. Маржинальна система, налаштована на спотові ціни, переоцінювала всі позиції під USDe на 35% нижче, провокуючи маржинальні виклики і масові ліквідації тисяч акаунтів.

Ці ліквідації породили додатковий тиск продажу на тому ж неліквідному ринку, що ще більше знизило ціни. Маржинальна система фіксувала ці нові нижчі ціни, знецінюючи ще більше позицій. Зворотній цикл перетворив $60 млн тиску продажу на $19,3 млрд примусових ліквідацій.

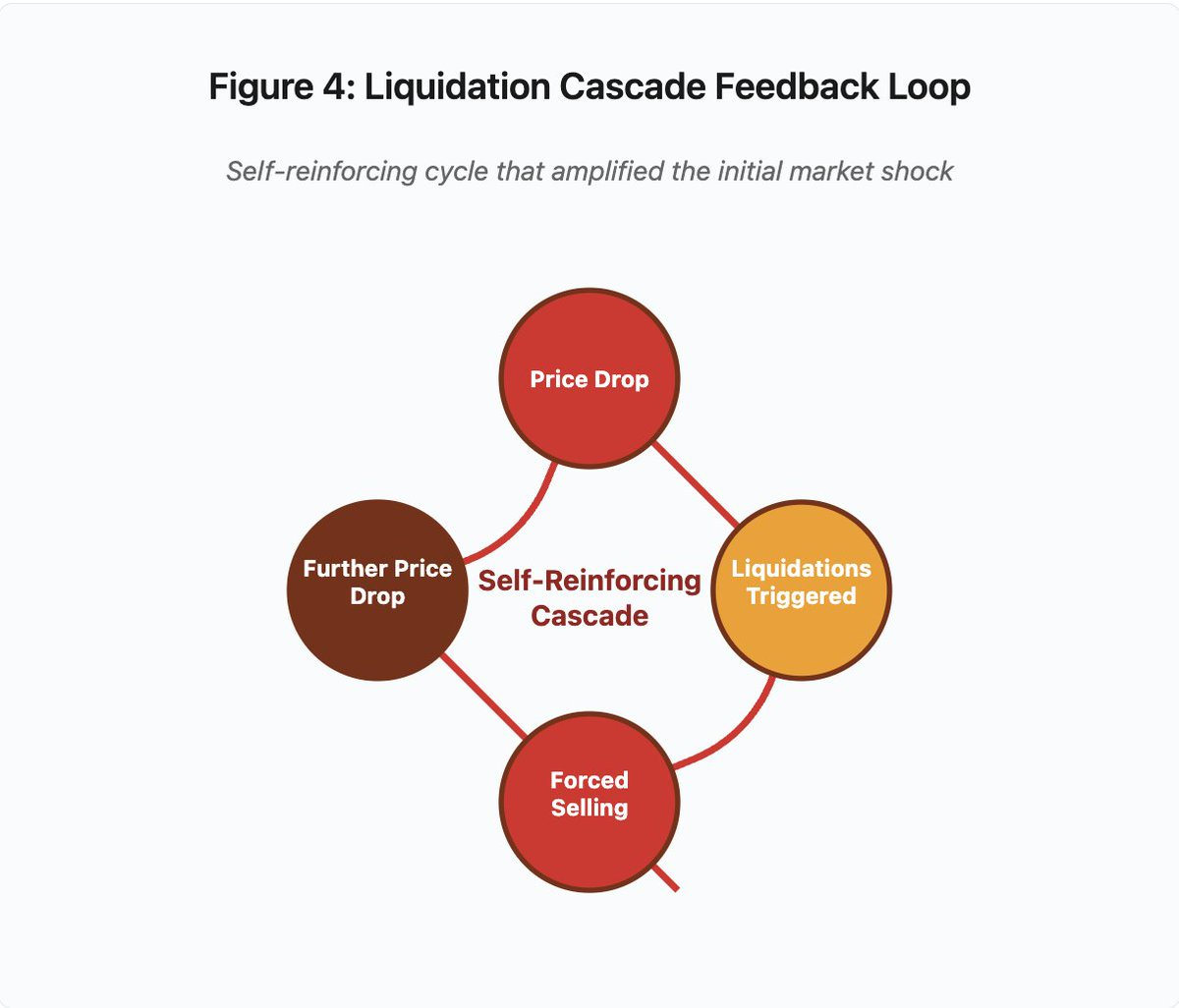

Рисунок 4: Зворотний цикл ліквідаційного каскаду

Кругова схема ілюструє самопідсилювальний характер каскаду:

Падіння ціни → Триггер ліквідацій → Примусовий продаж → Дальше падіння ціни → [цикл повторюється]

Цей механізм не спрацював би за коректного дизайну оракла. Якби Binance використовувала середньозважені ціни (TWAP) з кількох бірж, короткострокова маніпуляція не вплинула б на оцінку забезпечення. Якщо б застосовували агреговані фіди з Chainlink чи інших багатоджерельних ораклів, атака була б неможливою.

Схожа вразливість проявилася за чотири дні до каскаду у випадку wBETH. Wrapped Binance ETH (wBETH) має зберігати 1:1 конверсію з ETH, але під час каскаду ліквідність зникла, а спотовий ринок wBETH/ETH показав 20% дисконт. Маржинальна система відповідно знизила вартість забезпечення wBETH, що призвело до ліквідацій по повністю забезпечених ETH-позиціях.

Автоматичний делевереджинг (ADL)

Якщо ліквідацію неможливо виконати за поточними цінами, біржі застосовують Auto-Deleveraging, розподіляючи збитки між прибутковими трейдерами. ADL примусово закриває прибуткові позиції, щоб покрити дефіцит від ліквідованих.

Під час жовтневого каскаду Binance виконувала ADL на кількох парах. Трейдери з прибутковими позиціями отримували примусове закриття не через власні ризики, а через неплатоспроможність інших.

ADL — це фундаментальний вибір архітектури централізованих деривативних бірж. Біржі гарантують, що самі не втрачають коштів. Збитки поглинаються або:

- Страховими фондами (капітал біржі для покриття ліквідаційних дефіцитів)

- ADL (примусове закриття прибуткових позицій)

- Соціалізовані збитки (розподіл втрат між усіма користувачами)

Розмір страхового фонду щодо відкритого інтересу визначає частоту ADL. У жовтні 2025 року страховий фонд Binance складав близько $2 млрд. При $4 млрд відкритого інтересу це 50% покриття. Але у жовтневому каскаді відкритий інтерес перевищив $20 млрд, і фонд не міг покрити дефіцит.

Після події Binance повідомила, що гарантуватиме відсутність ADL для контрактів BTC, ETH, BNB USDⓈ-M при загальному відкритому інтересі до $4 млрд. Це створює стимул: біржі можуть тримати більші страхові фонди для уникнення ADL, але це блокує капітал, який міг би приносити прибуток.

Збої на блокчейні: обмеження протоколу

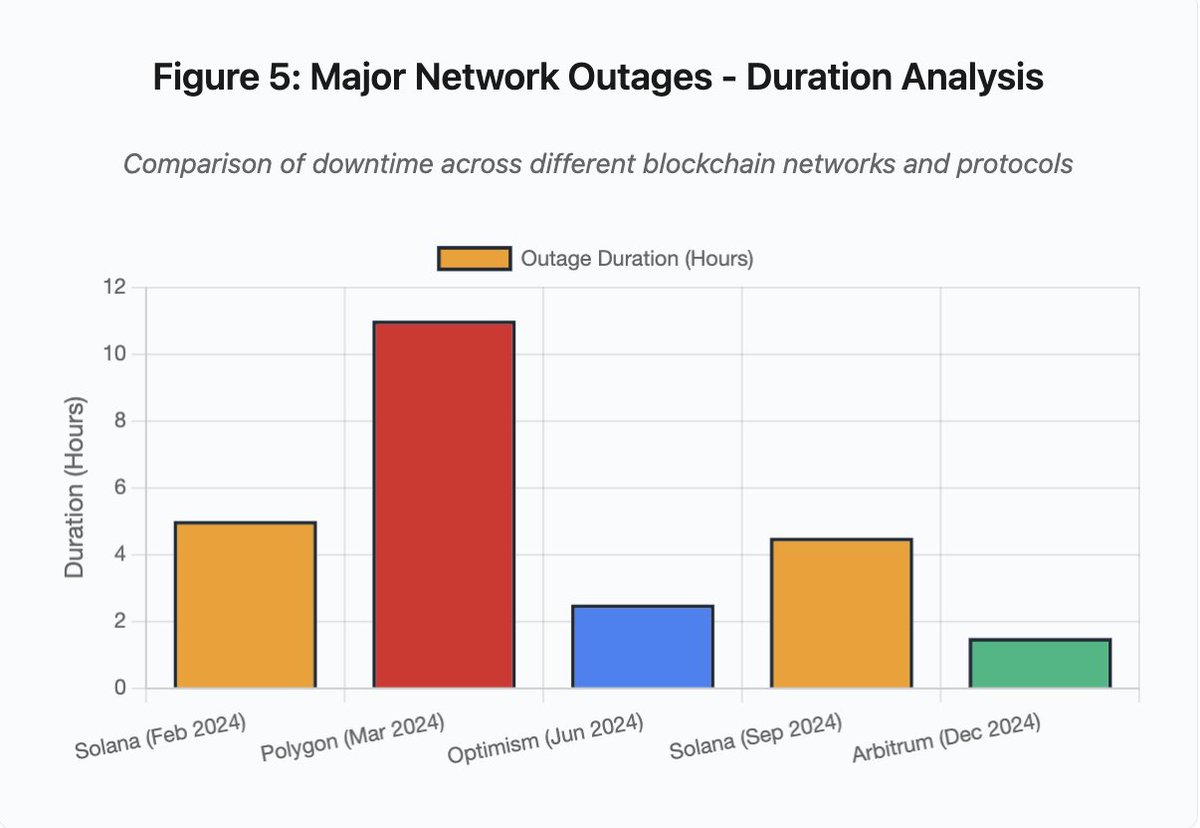

Графік у вигляді стовпців порівнює тривалість інцидентів:

- Solana (лютий 2024): 5 годин — вузьке місце голосування

- Polygon (березень 2024): 11 годин — розбіжність версій валідаторів

- Optimism (червень 2024): 2,5 години — перевантаження секвенсера (airdrop)

- Solana (вересень 2024): 4,5 години — атака спам-транзакціями

- Arbitrum (грудень 2024): 1,5 години — збій RPC-провайдера

Рисунок 5: Тривалість ключових мережевих збоїв

Solana: вузьке місце консенсусу

Solana пережила кілька збоїв у 2024–2025 роках. У лютому 2024 року збій тривав близько 5 годин, у вересні — 4,5 години. Причини подібні: неспроможність мережі обробити обсяг транзакцій при атаках спамом чи екстремальній активності.

Деталі: збої Solana (5 годин у лютому, 4,5 у вересні) підкреслюють повторювані проблеми з надійністю мережі під навантаженням.

Архітектура Solana оптимізована для високої пропускної здатності. За нормальних умов мережа обробляє 3 000–5 000 транзакцій/сек із субсекундною фіналізацією, суттєво випереджаючи Ethereum. Проте під навантаженням ця оптимізація породжує уразливості.

Збій у вересні 2024 року виник через спам-транзакції, що перевантажили механізми голосування валідаторів. Валідатори Solana мають голосувати за блоки для досягнення консенсусу. В штатному режимі вони пріоритизують голосування, але протокол раніше розглядав голоси як звичайні транзакції у fee market.

Коли mempool переповнився мільйонами спам-транзакцій, валідатори не могли поширити голоси. Без достатньої кількості голосів блоки не фіналізувалися, що призвело до зупинки ланцюга. Транзакції користувачів зависали, нові не проходили.

StatusGator задокументував численні збої Solana у 2024–2025 роках, які офіційно не визнавалися. Це породжує інформаційну асиметрію: користувачі не можуть відрізнити локальні проблеми від загальномережевих. Сторонній моніторинг підвищує прозорість, але платформи мають вести власні статус-сторінки.

Ethereum: вибух комісій за газ

Ethereum пережив екстремальні сплески комісій за газ у бум DeFi 2021 року. Вартість простих переказів перевищувала $100, складні взаємодії зі смарт-контрактами — $500–1 000. Це зробило мережу непридатною для дрібних транзакцій і відкрило вектор атак MEV.

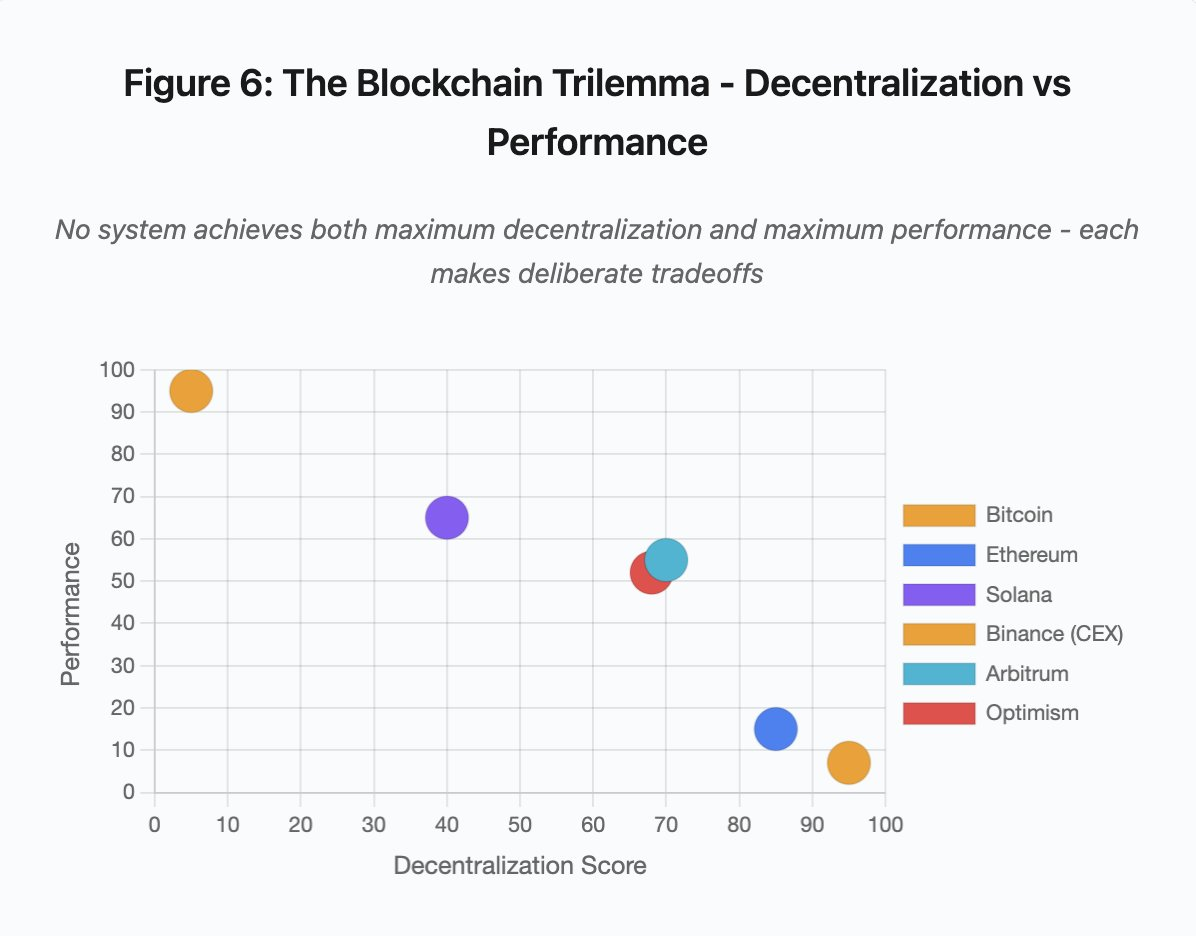

Рисунок 7: Вартість транзакцій під навантаженням

Графік чітко ілюструє ескалацію комісій за газ по мережах у стресових періодах:

- Ethereum: $5 (норма) → $450 (пік) — 90-кратне зростання

- Arbitrum: $0,50 → $15 — 30-кратне зростання

- Optimism: $0,30 → $12 — 40-кратне зростання

Візуалізація показує, що навіть Layer 2 зазнають суттєвої ескалації комісій, хоча стартовий рівень нижчий.

Maximal Extractable Value (MEV) — це прибутки валідаторів від переупорядкування, включення чи виключення транзакцій. У періоди високих комісій MEV особливо вигідний. Арбітражери змагаються за пріоритет великої DEX-торгівлі, боти ліквідації — за першочергове закриття недозабезпечених позицій. Це породжує війни ставок за газ.

Користувачі, які прагнуть провести транзакцію під час конгестії, змушені перебивати ставки MEV-ботів. Виникають ситуації, коли комісія перевищує суму транзакції. Щоб отримати $100 airdrop — потрібно заплатити $150 комісії; для уникнення ліквідації — конкурувати з ботами, які платять $500 за пріоритет.

Ліміт газу Ethereum обмежує загальну обчислювальну потужність на блок. Під час конгестії користувачі змагаються за дефіцитний простір у блоці. Fee market працює як задумано: вищі ставки — перші у черзі. Але це робить мережу дорожчою саме у критичні моменти, коли доступ потрібен найбільше.

Layer 2 вирішують цю проблему, переносячи обчислення поза ланцюгом, зберігаючи безпеку Ethereum через періодичний settlement. Optimism, Arbitrum та інші rollups обробляють тисячі транзакцій поза ланцюгом, потім подають стислі докази на Ethereum. Це дійсно знижує вартість транзакцій у штатному режимі.

Layer 2: вузьке місце секвенсера

Але Layer 2 створюють нові вузькі місця. Optimism зазнав збою, коли 250 000 адрес одночасно отримували airdrop у червні 2024 року. Секвенсер, який упорядковує транзакції перед подачею в Ethereum, був перевантажений. Користувачі не могли надсилати транзакції кілька годин.

Цей збій засвідчив, що перенос обчислень поза ланцюгом не скасовує потреби у масштабованій інфраструктурі. Секвенсери мають обробляти, упорядковувати, виконувати транзакції та генерувати докази для settlement. У піковий трафік секвенсери стикаються з такими самими проблемами масштабування, як і блокчейни.

Потрібна доступність кількох RPC-провайдерів. Якщо основний провайдер падає, користувачі мають автоматично переключатися на альтернативи. Під час збою Optimism частина RPC-провайдерів залишалася працюючою, інші — ні. Користувачі, чиї гаманці використовували недоступні провайдери, не могли взаємодіяти з мережею, хоча сама мережа залишалась активною.

Збої AWS неодноразово підтверджували ризик концентрації інфраструктури у криптоекосистемі:

- 20 жовтня 2025 року (сьогодні): збій у US-EAST-1, що вплинув на Coinbase, Venmo, Robinhood і Chime. AWS підтвердила підвищені показники помилок у DynamoDB і EC2.

- Квітень 2025 року: регіональний збій, що вплинув на Binance, KuCoin і MEXC одночасно. Коли компоненти AWS виходили з ладу, найбільші біржі ставали недоступними.

- Грудень 2021 року: збій US-EAST-1 призвів до зупинки Coinbase, Binance.US і «децентралізованої» дYdX на 8–9 годин, зачепивши склади Amazon і стрімінгові сервіси.

- Березень 2017 року: збій S3 не дозволяв користувачам входити в Coinbase і GDAX протягом п’яти годин, спричинивши масові перебої в інтернеті.

Закономірність очевидна: ці біржі розміщують критичні компоненти на AWS. Коли AWS переживає збій, одночасно стають недоступними кілька найбільших платформ. Користувачі не мають доступу до коштів, не можуть торгувати чи змінювати позиції саме під час ринкової волатильності.

Polygon: розбіжність версій консенсусу

Polygon (раніше Matic) пережив 11-годинний збій у березні 2024 року, спричинений розбіжністю версій ПО валідаторів: частина працювала на старому ПЗ, інші — на оновленому. Різні версії по-різному обробляли переходи стану.

Деталі: збій Polygon (11 годин) був найдовшим серед ключових інцидентів і підкреслює серйозність консенсусних збоїв.

Коли валідатори доходили до різних висновків щодо стану, консенсус руйнувався, і ланцюг не міг створювати нові блоки. Виникав тупик: старе ПЗ відкидало нові блоки, нове — старі.

Для вирішення потрібна синхронізація оновлень валідаторів. Це займає години чи дні у децентралізованій мережі. Hard fork зазвичай використовує триггер по висоті блоку, забезпечуючи одночасний запуск. Інкрементальні оновлення можуть створити той самий ризик розбіжності, що призвела до збою Polygon.

Архітектурні компроміси

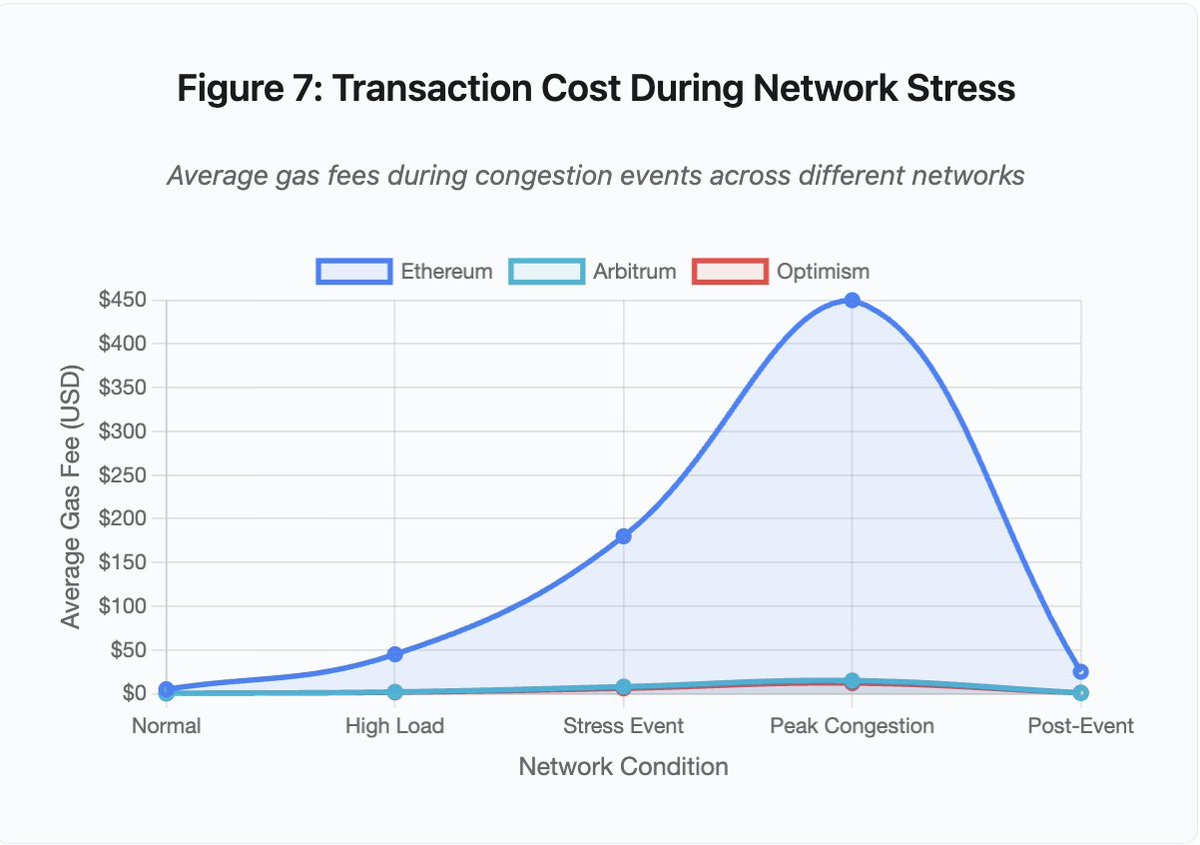

Рисунок 6: Блокчейн-трилема — децентралізація vs продуктивність

Діаграма розміщує системи за двома критичними параметрами:

- Bitcoin: висока децентралізація, низька продуктивність

- Ethereum: висока децентралізація, середня продуктивність

- Solana: середня децентралізація, висока продуктивність

- Binance (CEX): мінімальна децентралізація, максимальна продуктивність

- Arbitrum/Optimism: середньо-висока децентралізація, середня продуктивність

Висновок: жодна система не поєднує максимальну децентралізацію і максимальну продуктивність. Кожен дизайн — це свідомий компроміс під конкретні завдання.

Централізовані біржі забезпечують мінімальні затримки завдяки простій архітектурі: matching engine обробляє ордери за мікросекунди, стан зберігається у централізованих базах, відсутність консенсусу — мінімум оверхеду. Але це створює єдині точки відмови: при перевантаженні каскад збоїв поширюється по зв’язаних системах.

Децентралізовані протоколи розподіляють стан між валідаторами, ліквідуючи єдині точки відмови. Високопродуктивні ланцюги зберігають цю властивість у збої (коштів не втрачають, лише тимчасово порушується liveness). Проте консенсус між валідаторами — це додатковий оверхед. При розбіжності версій чи надмірному трафіку процес може зупинятися.

Додавання реплік підвищує fault tolerance, але збільшує координаційні витрати. Високопродуктивні архітектури мінімізують цей оверхед через оптимізацію комунікацій, забезпечуючи швидкість ціною певної уразливості. Безпекові архітектури роблять акцент на різноманітності валідаторів і надійності консенсусу, обмежуючи throughput для максимальної стійкості.

Layer 2 намагаються поєднати обидві властивості через ієрархічну структуру: вони наслідують безпеку Ethereum через L1 settlement і забезпечують високу пропускну здатність через off-chain обчислення. Однак це створює нові вузькі місця на рівні секвенсера і RPC, демонструючи, що додаткова складність породжує нові типи збоїв навіть при вирішенні інших.

Масштабування — фундаментальна проблема

Перераховані інциденти демонструють сталий патерн: системи працюють у штатних умовах, але катастрофічно ламаються під стресом. Solana ефективно обробляла рутинний трафік, але зупинилася при 10 000% прирості транзакцій. Комісії Ethereum залишалися прийнятними, поки масове DeFi не спровокувало конгестію. Optimism працював нормально, поки 250 000 адрес не отримали airdrop одночасно. API Binance витримували стандартну торгівлю, але стали вузьким місцем під час ліквідаційного каскаду.

Жовтнева подія ілюструє цю динаміку на рівні біржі. У штатному режимі ліміти API і підключень до бази даних достатні. Під час каскаду, коли кожен трейдер намагається одночасно змінити позицію, ці ліміти стають критичними. Маржинальна система, створена для захисту біржі через примусові ліквідації, посилила кризу, породивши масових продавців у найгірший момент.

Автоматичне масштабування не захищає від стрибкоподібних навантажень. Розгортання додаткових серверів займає хвилини, за які маржинальні системи оцінюють позиції за спотвореними цінами з тонких книг ордерів. Коли нові ресурси стають доступними, каскад вже розповсюдився.

Перемасштабування для рідкісних стресових подій коштує дорого у штатному режимі. Оператори оптимізують під звичайне навантаження, приймаючи періодичні збої як економічно раціональні. Вартість простоїв перекладається на користувачів, які стикаються з ліквідаціями, завислими транзакціями або недоступністю коштів у критичні моменти.

Інфраструктурні покращення

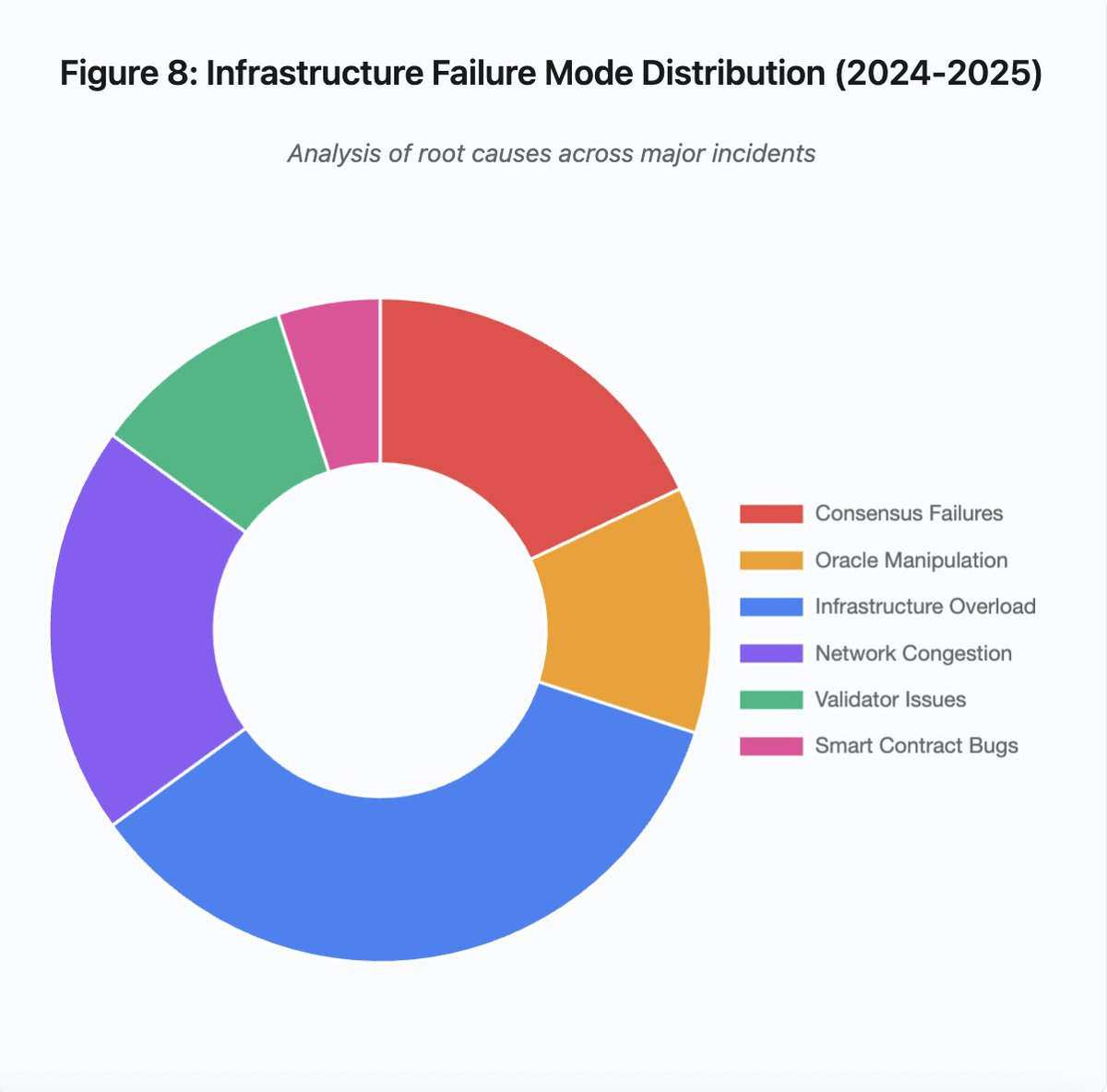

Рисунок 8: Причини інфраструктурних збоїв (2024–2025)

Кругова діаграма розподілу причин показує:

- Перевантаження інфраструктури: 35% (найпоширеніше)

- Конгестія мережі: 20%

- Збої консенсусу: 18%

- Маніпуляція ораклами: 12%

- Проблеми валідаторів: 10%

- Баги смарт-контрактів: 5%

Деякі архітектурні зміни можуть знизити частоту та серйозність збоїв, хоча кожна має свої компроміси:

1. Відокремлення систем ціноутворення і ліквідації

Жовтнева проблема виникла частково через прив’язку маржинальних розрахунків до спотових цін. Використання коефіцієнтів конверсії для wrapped-активів замість спотових цін дозволило б уникнути неправильного ціноутворення wBETH. В цілому критичні системи ризик-менеджменту не мають залежати від маніпульованих ринкових даних. Незалежні оракли з багатоджерельною агрегацією та TWAP — більш стійке рішення.

2. Перемасштабування і резервна інфраструктура

Квітневий збій AWS, що вплинув на Binance, KuCoin і MEXC, продемонстрував ризики концентрації інфраструктури. Розміщення критичних компонентів на різних хмарних провайдерах збільшує витрати й складність, але усуває синхронні збої. Layer 2 можуть підтримувати кілька RPC-провайдерів із автоматичним failover. Додаткові витрати здаються зайвими у штатному режимі, але запобігають багатогодинним простоям у пікові періоди.

3. Покращене стрес-тестування і планування потужностей

Патерн «працює, поки не ламається» свідчить про недостатнє тестування під навантаженням. Імітація 100-кратного навантаження має стати стандартом. Виявлення вузьких місць на етапі розробки дешевше, ніж у реальних збоях. Але реалістичне тестування складне: реальний трафік має патерни, які тестування не відтворює. Поведінка користувачів під час краху відрізняється від тестових сценаріїв.

Шлях уперед

Перемасштабування — найнадійніше рішення, але суперечить економічній доцільності. Утримання 10-кратного резерву для рідкісних подій дорого обходиться щодня. Поки катастрофічні збої не призведуть до достатніх втрат, щоб виправдати перемасштабування, системи й надалі ламаються під стресом.

Регуляторний тиск може змусити змінити підхід. Якщо вимагатимуть 99,9% uptime чи обмежать тривалість простоїв, біржі будуть змушені перемасштабуватися. Проте регуляції зазвичай з’являються після катастроф, а не запобігають їм. Крах Mt. Gox у 2014 році призвів до регулювання бірж у Японії. Каскад жовтня 2025 ймовірно спровокує схожі реакції. Чи це будуть вимоги до результату (максимальний простій, максимальний slippage під час ліквідацій) чи до реалізації (конкретні оракли, пороги circuit breaker) — невідомо.

Фундаментальна проблема — ці системи працюють цілодобово на глобальних ринках, але залежать від інфраструктури, призначеної для традиційних бізнес-годин. Коли стрес настає о 02:00, команди екстрено розгортають виправлення, а користувачі втрачають кошти. Традиційні ринки зупиняють торгівлю при стресі, крипторинки просто «розплавляються». Чи це перевага чи недолік — залежить від позиції та перспективи.

Технологічний прогрес блокчейн-систем за короткий час вражає. Підтримка розподіленого консенсусу між тисячами вузлів — це інженерний прорив. Однак щоб забезпечити надійність під навантаженням, потрібно перейти від прототипних архітектур до продукційної інфраструктури. Це дорого і вимагає пріоритету стійкості над швидкістю розвитку функцій.

Виклик — зберігати пріоритет стійкості над зростанням у бичачі ринки, коли всі заробляють, а простої здаються чужою проблемою. Наступний цикл виявить нові слабкі місця. Чи навчиться індустрія на жовтні 2025 чи повторить ті ж помилки — питання відкрите. Історія показує: наступна критична вразливість буде знайдена через чергову багатомільярдну втрату під стресом.

Аналіз базується на відкритих ринкових даних і офіційних заявах платформ. Всі думки — особисті, не є позицією жодної структури.

Відмова від відповідальності:

- Стаття є передруком з [yq_acc]. Всі авторські права — за оригінальним автором [yq_acc]. У разі зауважень до передруку, звертайтеся до команди Gate Learn — питання буде вирішено оперативно.

- Відмова від відповідальності: погляди автора — виключно його особисті й не є інвестиційною порадою.

- Переклад статті іншими мовами здійснює команда Gate Learn. За відсутності прямого дозволу копіювання, поширення чи плагіат перекладів заборонено.

Пов’язані статті

Що таке Coti? Все, що вам потрібно знати про COTI

Що таке Стейблкойн?

Все, що вам потрібно знати про Blockchain

Що таке Gate Pay?

Що таке BNB?