Infrastruktur Crypto Masih Belum Sempurna

Saat artikel ini dipublikasikan, Amazon Web Services kembali mengalami gangguan besar yang berdampak signifikan terhadap infrastruktur kripto. Sejak sekitar pukul 08.00 waktu Inggris hari ini, gangguan AWS di region US-EAST-1 (pusat data North Virginia) telah menyebabkan Coinbase dan puluhan platform kripto utama lainnya, termasuk Robinhood, Infura, Base, dan Solana, tidak dapat diakses.

AWS mengonfirmasi adanya “peningkatan tingkat error” yang mempengaruhi Amazon DynamoDB dan EC2—layanan basis data dan komputasi inti yang menjadi tulang punggung ribuan perusahaan. Gangguan real-time ini secara tegas dan langsung memvalidasi tesis utama artikel: ketergantungan infrastruktur kripto pada penyedia cloud terpusat menciptakan kerentanan sistemik yang berulang di bawah tekanan.

Waktu kejadian sangat signifikan. Hanya sepuluh hari setelah likuidasi senilai USD 19,3 miliar menguak kegagalan infrastruktur di tingkat bursa, gangguan AWS hari ini membuktikan bahwa masalahnya tidak hanya terjadi pada platform individu, tetapi juga pada lapisan infrastruktur cloud yang mendasarinya. Ketika AWS gagal, dampak berantai terjadi pada bursa terpusat, platform “terdesentralisasi” yang bergantung pada sentralisasi, dan berbagai layanan lainnya secara serempak.

Ini bukanlah insiden terpisah, melainkan sebuah pola berulang. Analisis berikut mendokumentasikan gangguan AWS serupa pada April 2025, Desember 2021, dan Maret 2017, di mana setiap kejadian menumbangkan layanan kripto utama. Pertanyaannya bukan apakah kegagalan infrastruktur berikutnya akan terjadi, melainkan kapan serta apa pemicunya.

Cascade Likuidasi 10–11 Oktober 2025: Studi Kasus

Cascade likuidasi 10–11 Oktober 2025 menjadi studi kasus penting mengenai mode kegagalan infrastruktur. Pada pukul 20.00 UTC, pengumuman geopolitik utama memicu aksi jual di seluruh pasar. Dalam satu jam, terjadi likuidasi senilai USD 6 miliar. Saat pasar Asia dibuka, posisi leverage senilai USD 19,3 miliar telah lenyap di 1,6 juta akun trader.

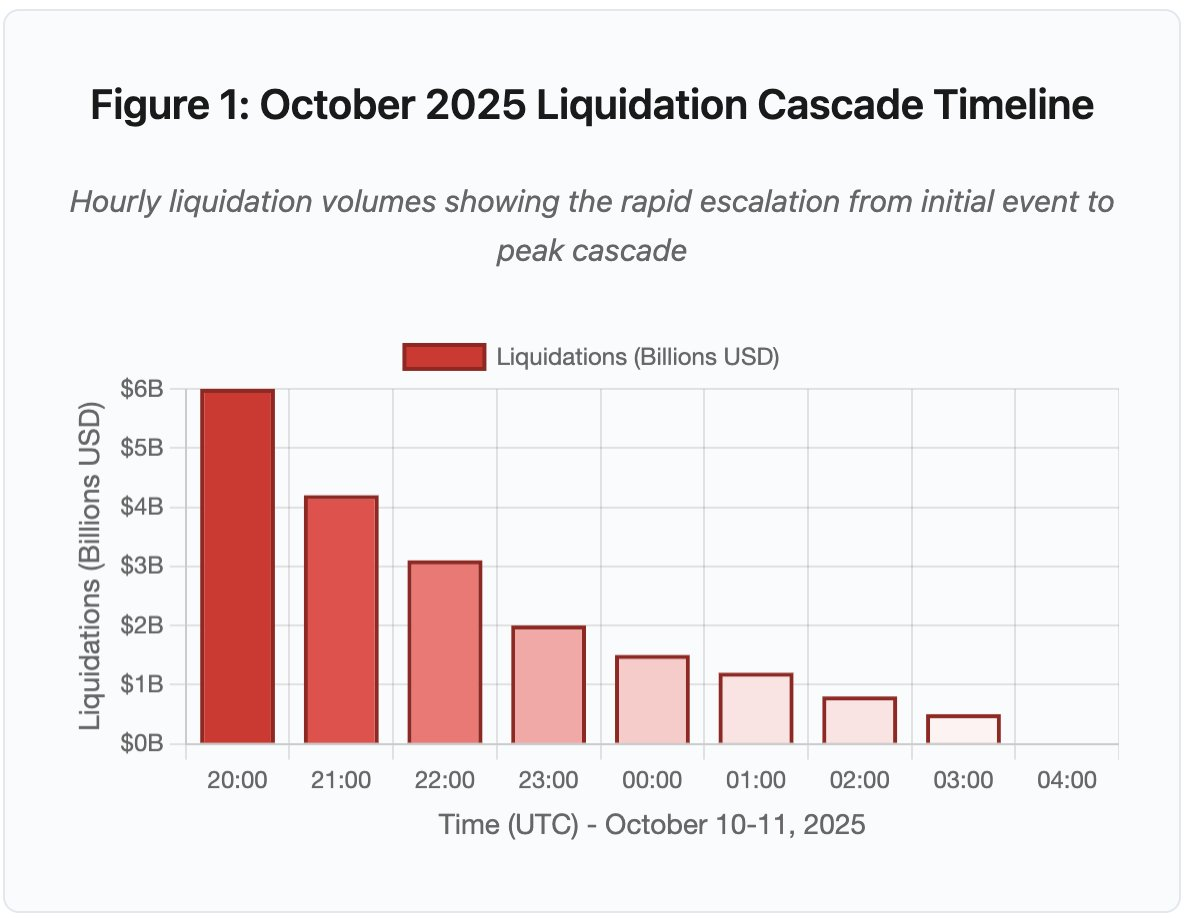

Gambar 1: Linimasa Cascade Likuidasi Oktober 2025

Grafik linimasa interaktif memperlihatkan perkembangan dramatis likuidasi dari jam ke jam. Hanya dalam satu jam pertama, USD 6 miliar menguap, diikuti oleh jam kedua yang lebih intens saat cascade meningkat. Visualisasi ini menampilkan:

- 20.00–21.00: Guncangan awal – USD 6 miliar dilikuidasi (zona merah)

- 21.00–22.00: Puncak cascade – USD 4,2 miliar saat pembatasan API dimulai

- 22.00–04.00: Degradasi berkepanjangan – USD 9,1 miliar di pasar tipis

- Titik kritis: pembatasan laju API, mundurnya market maker, penipisan order book

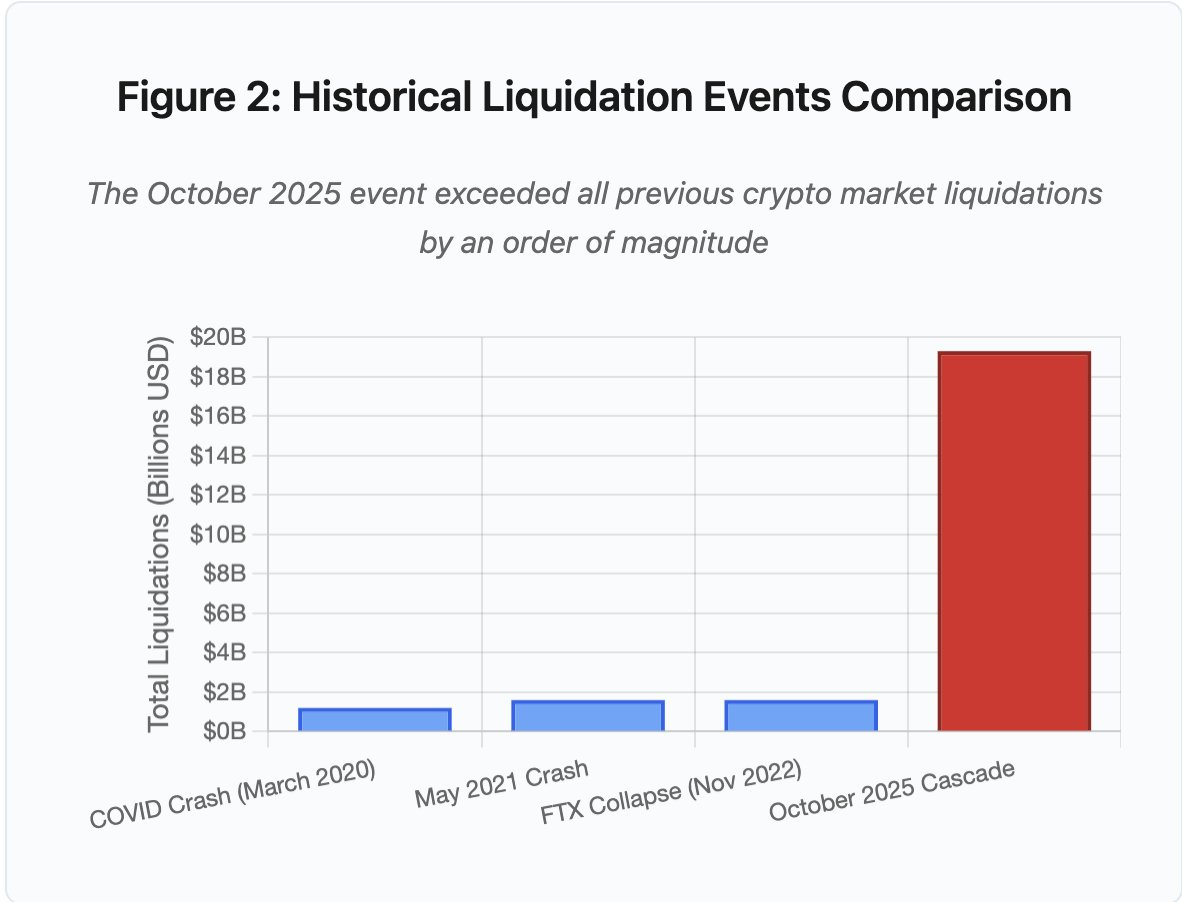

Skalanya melampaui peristiwa pasar kripto sebelumnya setidaknya satu tingkat besaran. Perbandingan historis menunjukkan karakter loncatan event ini:

Gambar 2: Perbandingan Peristiwa Likuidasi Historis

Grafik batang tersebut secara nyata mengilustrasikan betapa Oktober 2025 sangat berbeda:

- Maret 2020 (COVID): USD 1,2 miliar

- Mei 2021 (Crash): USD 1,6 miliar

- November 2022 (FTX): USD 1,6 miliar

- Oktober 2025: USD 19,3 miliar ⚠️ 16x rekor tertinggi sebelumnya

Namun angka likuidasi hanya bagian dari cerita. Pertanyaan utama adalah mekanismenya: bagaimana peristiwa eksternal pasar memicu mode kegagalan spesifik ini? Jawabannya mengungkap kelemahan sistemik baik pada infrastruktur bursa terpusat maupun desain protokol blockchain.

Kegagalan Off-Chain: Arsitektur Bursa Terpusat

Overload Infrastruktur dan Pembatasan Laju

API bursa menerapkan pembatasan laju (rate limit) untuk mencegah penyalahgunaan dan mengelola beban server. Dalam operasional normal, pembatasan ini memungkinkan transaksi sah sambil memblokir serangan. Namun saat volatilitas ekstrem, ketika ribuan trader secara bersamaan menyesuaikan posisi, pembatasan yang sama justru menjadi bottleneck.

CEX membatasi notifikasi likuidasi menjadi satu order per detik, meski memproses ribuan per detik. Selama cascade Oktober, hal ini menciptakan kurang transparansi. Pengguna tidak dapat mengamati tingkat keparahan cascade secara real-time. Alat pemantau pihak ketiga menunjukkan ratusan likuidasi per menit, sedangkan feed resmi jauh lebih sedikit.

Pembatasan laju API menghalangi trader memodifikasi posisi pada jam krusial pertama. Permintaan koneksi time-out. Order gagal dikirim. Stop-loss gagal dieksekusi. Query posisi mengembalikan data kadaluarsa. Bottleneck ini mengubah event pasar menjadi krisis operasional.

Bursa tradisional menyiapkan infrastruktur untuk beban normal plus margin keamanan. Namun beban normal sangat berbeda dari beban stres. Volume trading harian rata-rata bukan prediktor akurat kebutuhan puncak. Saat cascade, volume transaksi bisa melonjak 100x lipat. Query data posisi meningkat 1.000x karena semua pengguna mengecek akun secara bersamaan.

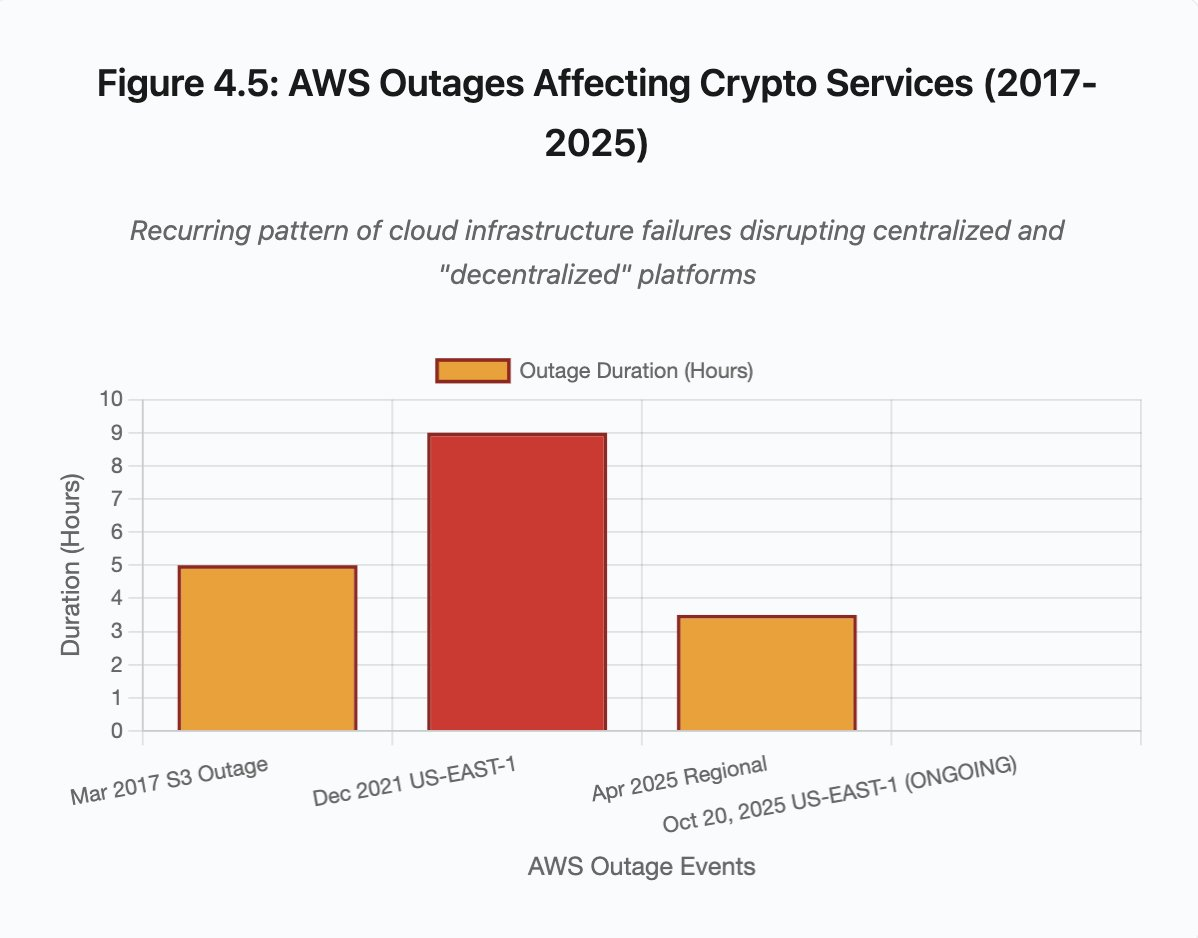

Gambar 4.5: Gangguan AWS yang Memengaruhi Layanan Kripto

Infrastruktur cloud auto-scaling membantu, tetapi tidak dapat merespons secara instan. Penambahan database read replica membutuhkan waktu beberapa menit. Membuat instance API gateway baru juga membutuhkan menit. Dalam waktu tersebut, sistem margin tetap menandai posisi berdasarkan data harga yang rusak dari order book yang kelebihan beban.

Manipulasi Oracle dan Kerentanan Harga

Selama cascade Oktober, pilihan desain krusial pada sistem margin menjadi jelas: beberapa bursa menghitung nilai jaminan berdasarkan harga spot internal, bukan feed oracle eksternal. Dalam kondisi pasar normal, arbitrase menjaga keselarasan harga antar platform. Namun saat infrastruktur tertekan, keterkaitan ini terputus.

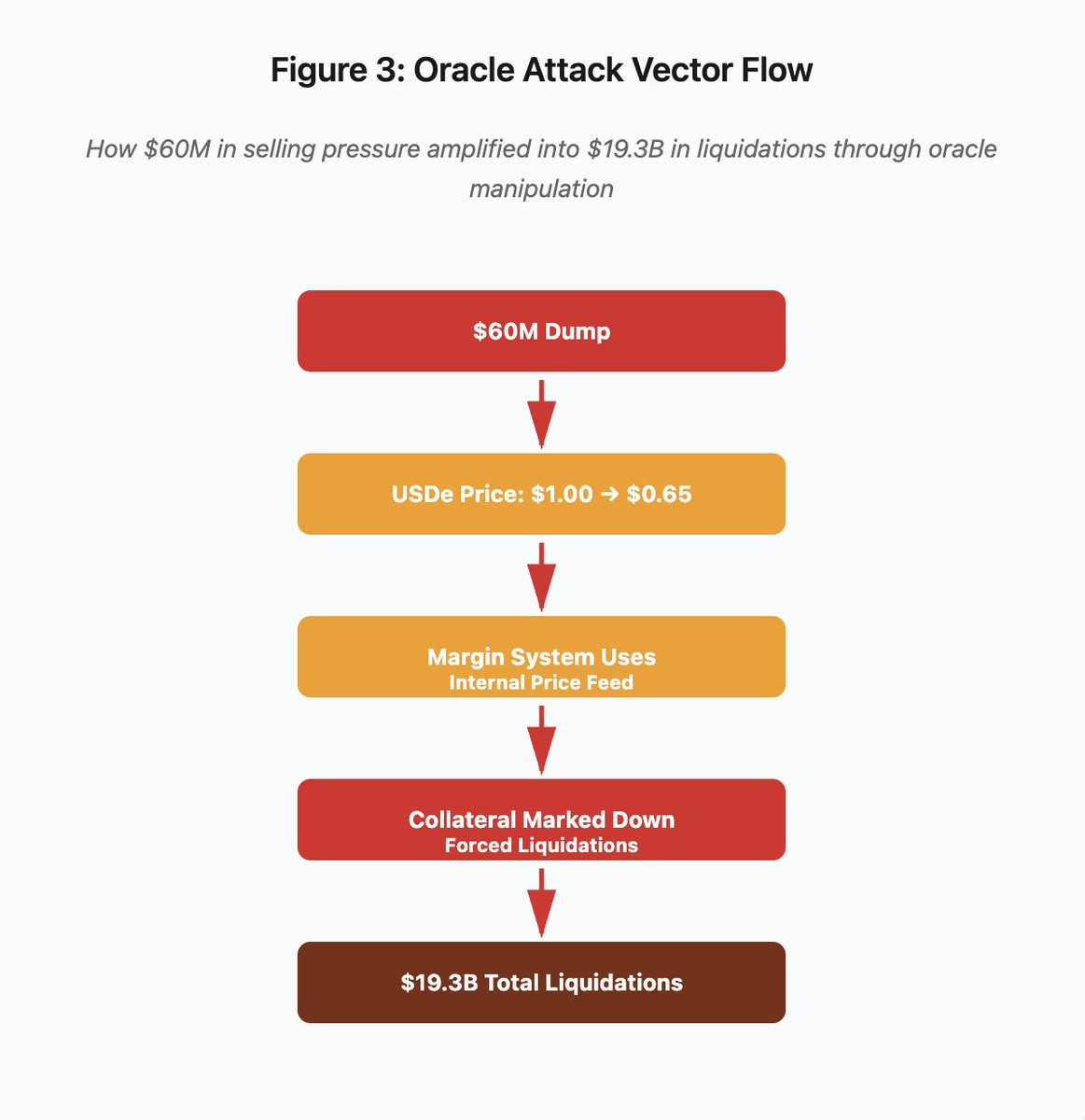

Gambar 3: Diagram Alur Manipulasi Oracle

Diagram alur interaktif menggambarkan vektor serangan dalam lima tahap:

- Dump Awal: tekanan jual USD 60 juta pada USDe

- Manipulasi Harga: USDe jatuh dari USD 1,00 → USD 0,65 di satu bursa

- Kegagalan Oracle: sistem margin menggunakan feed harga internal yang rusak

- Pemicu Cascade: jaminan diturunkan, likuidasi paksa dimulai

- Amplifikasi: total likuidasi USD 19,3 miliar (322x amplifikasi)

Serangan memanfaatkan penggunaan harga spot oleh Binance untuk jaminan sintetik wrapped. Ketika penyerang membuang USD 60 juta USDe ke order book tipis, harga spot jatuh dari USD 1,00 ke USD 0,65. Sistem margin yang menandai jaminan berdasarkan harga spot menurunkan nilai posisi berjaminan USDe sebesar 35%. Hal ini memicu margin call dan likuidasi paksa di ribuan akun.

Likuidasi tersebut memaksa penjualan lebih lanjut di pasar yang sama, menekan harga makin dalam. Sistem margin mencatat harga lebih rendah dan menurunkan nilai posisi lagi. Feedback loop ini mengamplifikasi tekanan jual USD 60 juta menjadi likuidasi paksa USD 19,3 miliar.

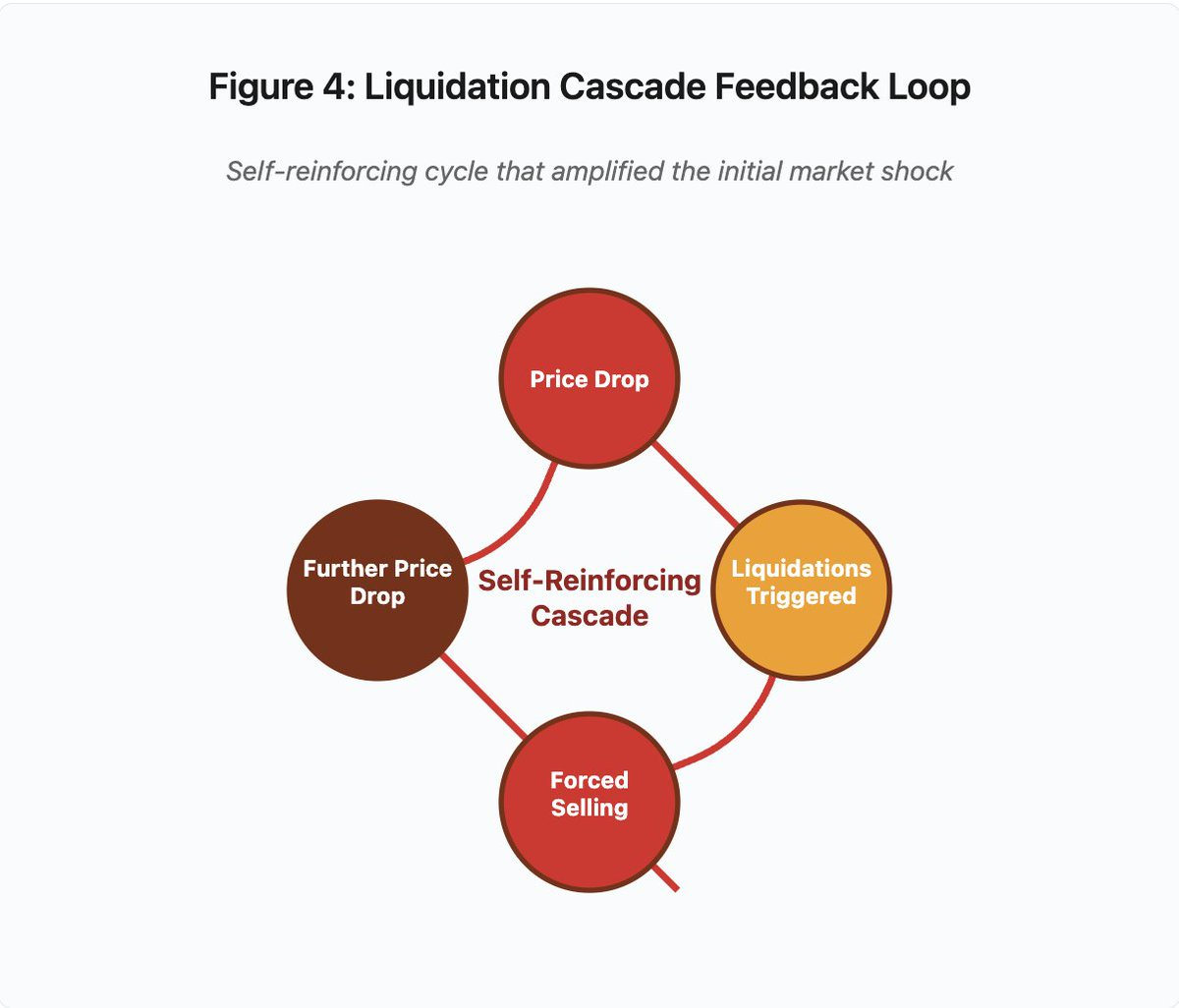

Gambar 4: Feedback Loop Cascade Likuidasi

Diagram feedback sirkular mengilustrasikan sifat saling memperkuat dari cascade:

Penurunan Harga → Likuidasi Dipicu → Penjualan Paksa → Penurunan Harga Lebih Lanjut → [siklus berulang]

Mekanisme ini tidak akan terjadi jika sistem oracle didesain dengan baik. Jika Binance menggunakan harga rata-rata berbobot waktu (TWAP) lintas bursa, manipulasi harga sesaat tidak akan memengaruhi valuasi jaminan. Jika menggunakan feed harga teragregasi dari Chainlink atau oracle multi-sumber lainnya, serangan gagal.

Insiden wBETH empat hari sebelumnya menunjukkan kerentanan serupa. Wrapped Binance ETH (wBETH) seharusnya mempertahankan rasio konversi 1:1 dengan ETH. Saat cascade, likuiditas mengering dan pasar spot wBETH/ETH menunjukkan diskon 20%. Sistem margin menurunkan nilai jaminan wBETH sesuai, memicu likuidasi pada posisi yang sebenarnya sepenuhnya dijamin oleh ETH di bawahnya.

Mekanisme Auto-Deleveraging (ADL)

Ketika likuidasi tidak dapat dieksekusi pada harga pasar saat ini, bursa menerapkan Auto-Deleveraging untuk mensosialisasikan kerugian kepada trader yang profit. ADL secara paksa menutup posisi profit pada harga terkini demi menutup kekurangan dari posisi yang dilikuidasi.

Selama cascade Oktober, Binance mengeksekusi ADL pada beberapa pasangan perdagangan. Trader dengan posisi long yang profit mendapati transaksi mereka ditutup paksa, bukan karena kegagalan manajemen risiko pribadi, melainkan karena posisi trader lain menjadi tidak solvent.

ADL mencerminkan pilihan arsitektural fundamental pada perdagangan derivatif terpusat. Bursa menjamin tidak akan merugi. Artinya, kerugian harus diserap oleh:

- Dana asuransi (modal bursa untuk menutup kekurangan likuidasi)

- ADL (memaksa trader profit menutup posisi)

- Kerugian sosial (membagi kerugian ke semua pengguna)

Ukuran dana asuransi dibandingkan interest terbuka menentukan frekuensi ADL. Dana asuransi Binance sekitar USD 2 miliar Oktober 2025. Terhadap interest terbuka USD 4 miliar di kontrak perpetual BTC, ETH, dan BNB, ini setara 50% perlindungan. Namun selama cascade Oktober, interest terbuka melampaui USD 20 miliar di seluruh pasangan. Dana asuransi tidak cukup menutup kekurangan.

Pasca cascade Oktober, Binance mengumumkan mereka akan menjamin tidak ada ADL untuk kontrak BTC, ETH, dan BNB USDⓈ-M jika total interest terbuka di bawah USD 4 miliar. Ini menciptakan insentif: bursa dapat mempertahankan dana asuransi lebih besar untuk menghindari ADL, namun modal tersebut terikat dan tidak dapat diputar secara produktif.

Kegagalan On-Chain: Keterbatasan Protokol Blockchain

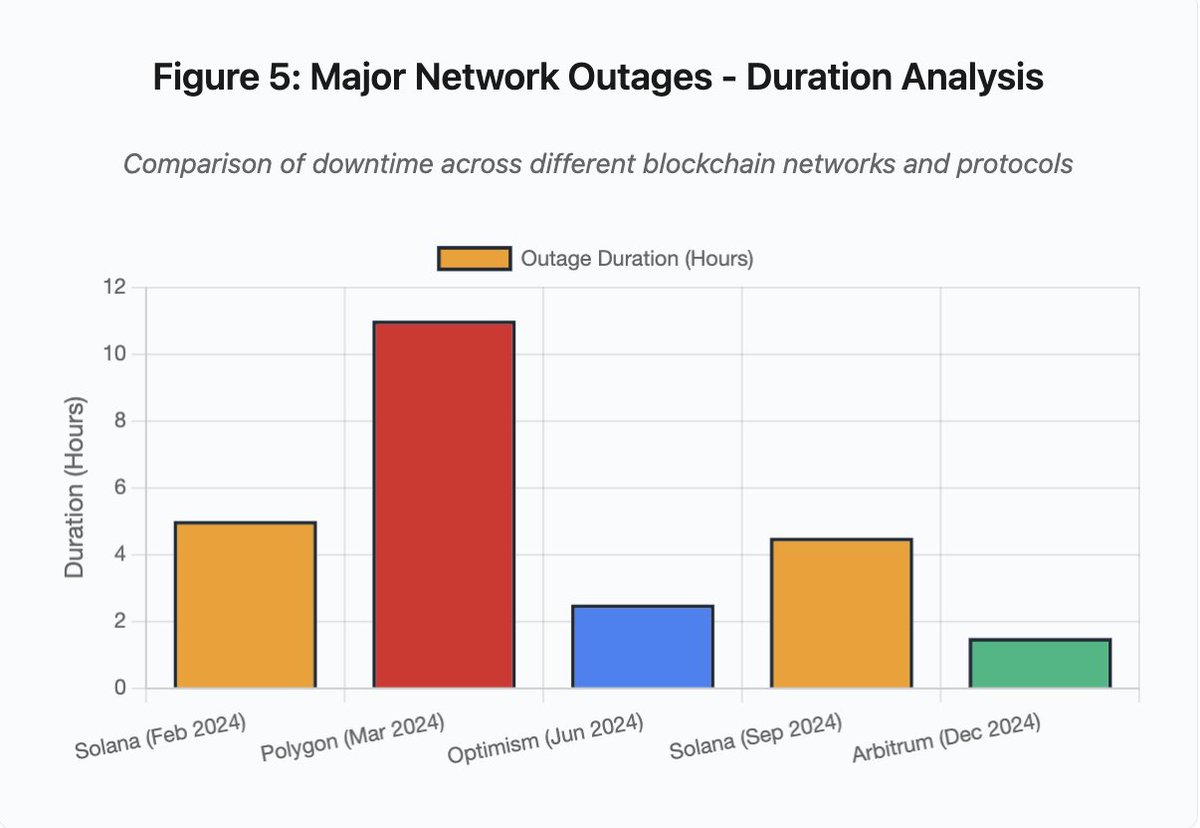

Grafik batang membandingkan durasi downtime berbagai insiden:

- Solana (Feb 2024): 5 jam – bottleneck voting throughput

- Polygon (Mar 2024): 11 jam – mismatch versi validator

- Optimism (Jun 2024): 2,5 jam – sequencer overload (airdrop)

- Solana (Sep 2024): 4,5 jam – serangan spam transaksi

- Arbitrum (Des 2024): 1,5 jam – kegagalan provider RPC

Gambar 5: Gangguan Jaringan Utama – Analisis Durasi

Solana: Bottleneck Konsensus

Solana mengalami beberapa outage selama 2024–2025. Outage Februari 2024 berlangsung sekitar 5 jam, dan outage September 2024 berlangsung 4–5 jam. Kedua outage ini disebabkan oleh akar masalah serupa: ketidakmampuan jaringan memproses volume transaksi saat serangan spam atau aktivitas ekstrem.

Detail Gambar 5: Outage Solana (5 jam di Februari, 4,5 jam di September) menyoroti masalah berulang pada resiliensi jaringan di bawah tekanan.

Arsitektur Solana dioptimalkan untuk throughput tinggi. Dalam kondisi ideal, jaringan memproses 3.000–5.000 transaksi per detik dengan finalisasi di bawah satu detik. Kinerja ini melampaui Ethereum beberapa tingkat besaran. Namun saat event stres, optimasi ini menciptakan kerentanan.

Outage September 2024 disebabkan banjir transaksi spam yang membebani mekanisme voting validator. Validator Solana harus melakukan voting pada block agar konsensus tercapai. Dalam operasi normal, validator memprioritaskan transaksi vote untuk memastikan konsensus berjalan. Namun protokol sebelumnya memperlakukan vote seperti transaksi biasa dalam fee market.

Saat mempool transaksi dipenuhi jutaan spam, validator kesulitan memproses transaksi vote. Tanpa suara yang memadai, block tidak dapat difinalisasi. Tanpa block final, chain terhenti. Pengguna yang memiliki transaksi tertunda melihat transaksi mereka tertahan di mempool. Pengajuan transaksi baru gagal dikirim.

StatusGator mendokumentasikan beberapa gangguan layanan Solana pada 2024–2025 yang tidak diakui secara resmi oleh Solana. Ini menciptakan asimetri informasi. Pengguna tidak dapat membedakan gangguan lokal dan masalah jaringan secara luas. Layanan pemantau pihak ketiga memberikan akuntabilitas, namun platform seharusnya menyediakan status page komprehensif.

Ethereum: Ledakan Biaya Gas

Ethereum mengalami lonjakan biaya gas ekstrem saat boom DeFi 2021. Biaya transaksi melebihi USD 100 untuk transfer sederhana. Interaksi smart contract kompleks menelan biaya USD 500–1.000. Biaya ini membuat jaringan tidak layak untuk transaksi kecil sekaligus membuka vektor serangan baru: ekstraksi MEV.

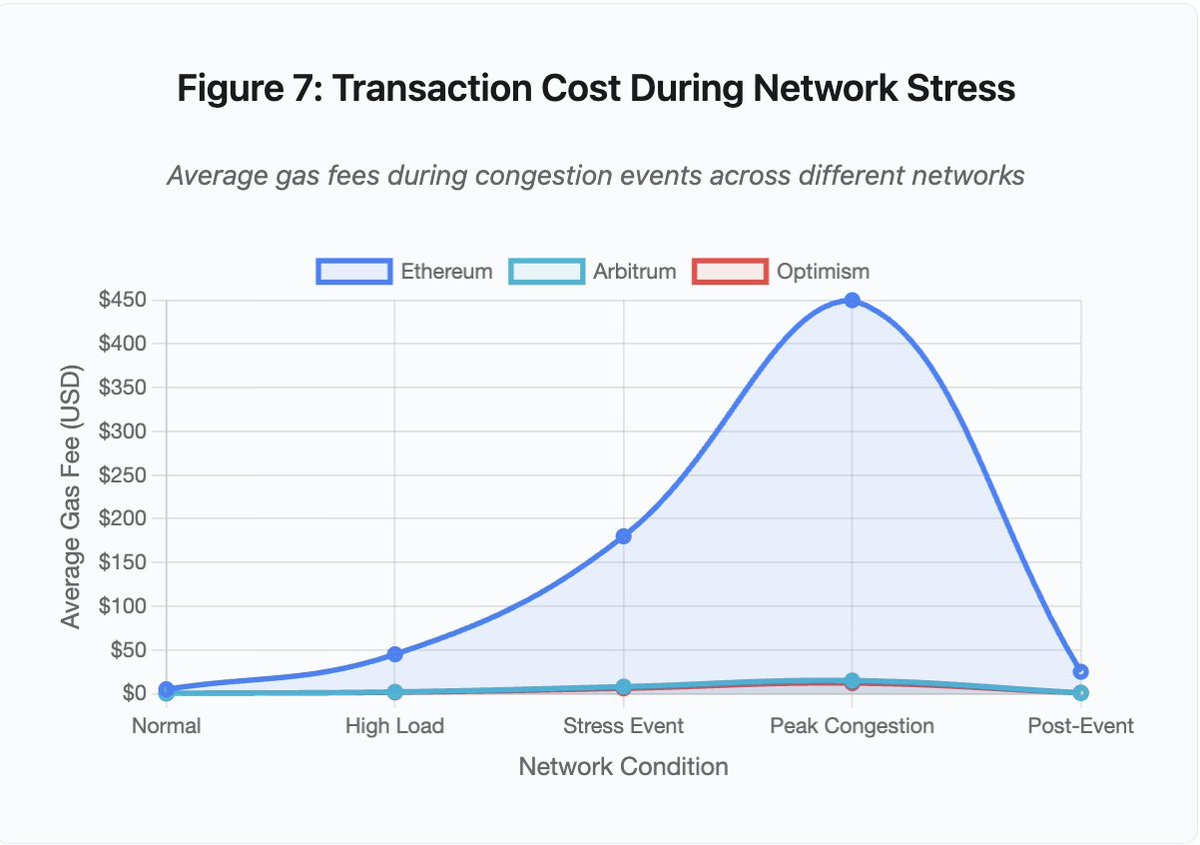

Gambar 7: Biaya Transaksi Saat Stres Jaringan

Grafik garis tersebut menunjukkan eskalasi biaya gas lintas jaringan saat event stres:

- Ethereum: USD 5 (normal) → USD 450 (puncak kemacetan) – kenaikan 90x

- Arbitrum: USD 0,50 → USD 15 – kenaikan 30x

- Optimism: USD 0,30 → USD 12 – kenaikan 40x

Visualisasi ini memperlihatkan bahwa solusi Layer 2 pun tetap mengalami eskalasi biaya, walau dari basis yang jauh lebih rendah.

Maximal Extractable Value (MEV) adalah profit yang dapat diambil validator dengan mengurutkan, memasukkan, atau mengecualikan transaksi. Saat biaya gas tinggi, MEV jadi sangat menguntungkan. Arbitrase berlomba mem-front-run transaksi DEX besar. Bot likuidasi berlomba melikuidasi posisi undercollateralized secepat mungkin. Kompetisi ini memicu perang harga gas.

Pengguna yang ingin memastikan transaksi masuk di tengah kemacetan harus mengalahkan bot MEV. Ini menciptakan situasi di mana biaya transaksi melebihi nilai transaksinya. Ingin klaim airdrop USD 100? Bayar gas USD 150. Ingin menambah jaminan agar tak dilikuidasi? Bersaing dengan bot yang rela bayar USD 500 untuk prioritas.

Gas limit Ethereum membatasi total komputasi per block. Saat kemacetan, pengguna berlomba merebut ruang block yang terbatas lewat bidding fee. Mekanisme fee market berjalan sesuai desain: bid tertinggi mendapat prioritas. Namun desain ini membuat jaringan makin mahal saat traffic tinggi—justru saat pengguna paling butuh akses.

Solusi Layer 2 berupaya mengatasi masalah ini dengan memindahkan komputasi off-chain, namun tetap mewarisi keamanan Ethereum lewat settlement periodik. Optimism, Arbitrum, dan solusi rollup lain memproses ribuan transaksi off-chain lalu mengirimkan proof terkompresi ke Ethereum. Arsitektur ini efektif menurunkan biaya per transaksi dalam operasi normal.

Layer 2: Bottleneck Sequencer

Namun solusi Layer 2 menghadirkan bottleneck baru. Optimism mengalami outage ketika 250.000 alamat secara serentak klaim airdrop pada Juni 2024. Sequencer—komponen yang mengurutkan transaksi sebelum dikirim ke Ethereum—kewalahan. Pengguna tidak dapat mengirim transaksi selama beberapa jam.

Outage ini menunjukkan bahwa pemindahan komputasi off-chain tidak mengeliminasi kebutuhan infrastruktur. Sequencer harus memproses, mengurutkan, mengeksekusi, dan menghasilkan fraud proof atau ZK proof untuk settlement Ethereum. Saat traffic ekstrem, sequencer menghadapi tantangan scaling yang sama seperti blockchain mandiri.

Provider RPC harus tersedia secara multiple. Jika provider utama gagal, pengguna harus otomatis failover ke alternatif. Selama outage Optimism, beberapa provider RPC tetap berjalan, lainnya gagal. Wallet yang default ke provider gagal tidak bisa berinteraksi dengan chain, walau chain tetap live.

Gangguan AWS berulang kali menunjukkan risiko infrastruktur terpusat di ekosistem kripto:

- 20 Oktober 2025 (Hari Ini): Outage region US-EAST-1 memengaruhi Coinbase, Venmo, Robinhood, dan Chime. AWS mengonfirmasi peningkatan error rate pada layanan DynamoDB dan EC2.

- April 2025: Outage regional memengaruhi Binance, KuCoin, dan MEXC secara simultan. Beberapa bursa besar tidak tersedia saat komponen AWS mereka gagal.

- Desember 2021: Outage US-EAST-1 menjatuhkan Coinbase, Binance.US, dan DEX “terdesentralisasi” dYdX selama 8–9 jam, serta berdampak pada gudang Amazon dan layanan streaming utama.

- Maret 2017: Outage S3 mencegah login ke Coinbase dan GDAX selama lima jam serta gangguan internet luas.

Polanya jelas: bursa-bursa ini menghosting komponen kritis di infrastruktur AWS. Ketika AWS mengalami outage regional, sejumlah bursa dan layanan utama serentak tidak tersedia. Pengguna tidak dapat mengakses dana, mengeksekusi trade, atau mengubah posisi selama outage—tepat saat volatilitas pasar menuntut aksi cepat.

Polygon: Mismatch Versi Konsensus

Polygon (sebelumnya Matic) mengalami outage selama 11 jam pada Maret 2024. Akar masalahnya adalah mismatch versi validator. Sebagian validator menjalankan software versi lama, sebagian lain versi baru. Versi ini menghitung transisi state secara berbeda.

Detail Gambar 5: Outage Polygon (11 jam) adalah yang terpanjang di antara insiden utama yang dianalisis, menyoroti parahnya kegagalan konsensus.

Saat validator sampai pada kesimpulan berbeda tentang state yang benar, konsensus gagal. Chain tidak bisa menghasilkan block baru karena validator tidak sepakat soal validitas block. Terjadi deadlock: validator lama menolak block dari validator baru, validator baru menolak block dari validator lama.

Resolusi membutuhkan koordinasi upgrade validator. Namun koordinasi saat outage memakan waktu. Operator validator harus dihubungi, deploy software versi terbaru, dan restart validator. Di jaringan terdesentralisasi dengan ratusan validator independen, proses ini bisa berlangsung berjam-jam hingga berhari-hari.

Hard fork biasanya menggunakan trigger block height. Semua validator upgrade di block height tertentu, memastikan aktivasi simultan. Namun ini membutuhkan koordinasi jauh hari sebelumnya. Upgrade bertahap, di mana validator mengadopsi versi baru secara gradual, berisiko menimbulkan mismatch versi seperti pada outage Polygon.

Trade-off Arsitektural

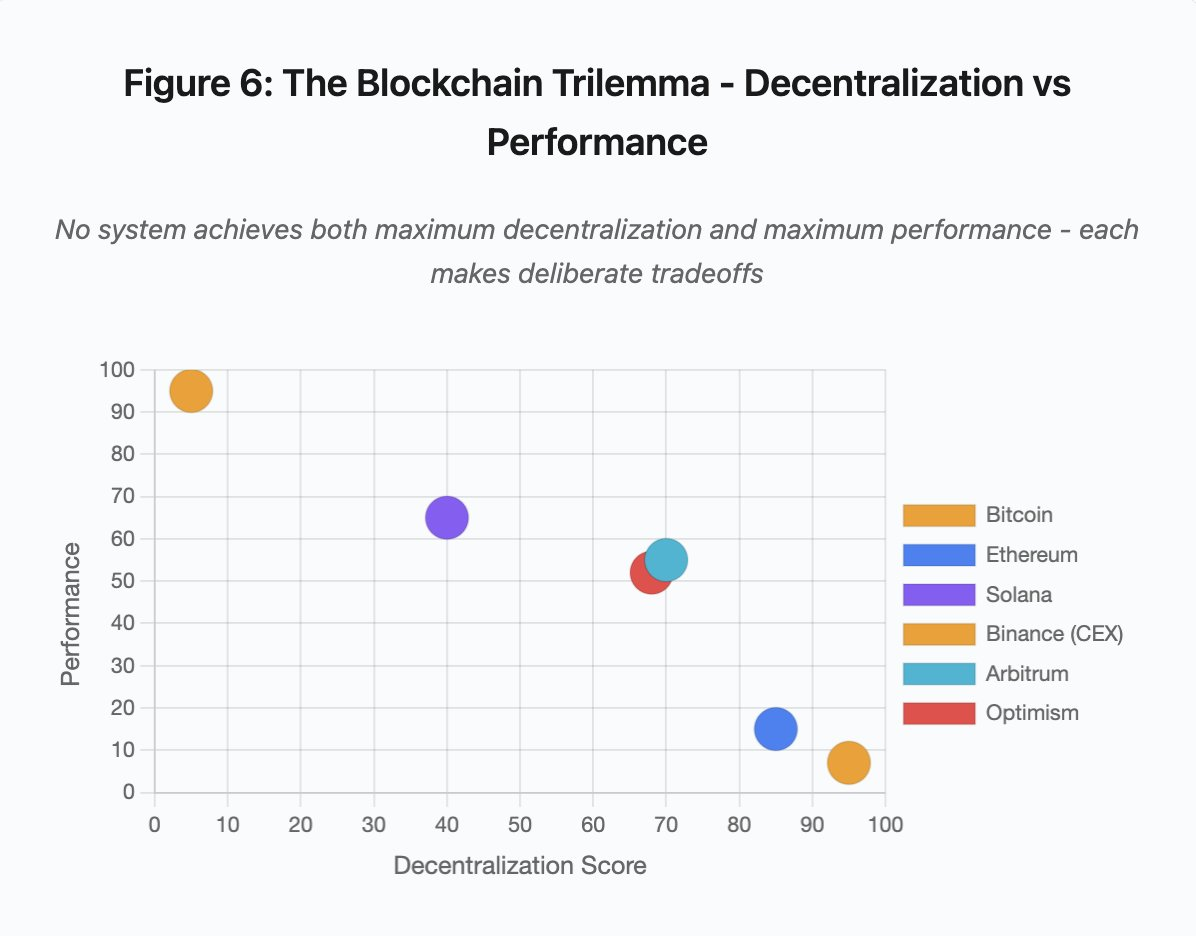

Gambar 6: Trilema Blockchain – Desentralisasi vs Kinerja

Visualisasi scatter plot memetakan sistem pada dua dimensi utama:

- Bitcoin: Desentralisasi tinggi, kinerja rendah

- Ethereum: Desentralisasi tinggi, kinerja sedang

- Solana: Desentralisasi menengah, kinerja tinggi

- Binance (CEX): Minim desentralisasi, kinerja maksimum

- Arbitrum/Optimism: Desentralisasi menengah-tinggi, kinerja menengah

Inti utama: Tidak ada sistem yang mencapai desentralisasi maksimum sekaligus kinerja maksimum. Setiap desain melakukan trade-off terukur untuk kebutuhan berbeda.

Bursa terpusat meraih latensi rendah lewat arsitektur sederhana. Matching engine memproses order dalam mikrodetik. State tersimpan di database sentral. Tanpa protokol konsensus, tidak ada overhead. Namun kesederhanaan ini menciptakan titik kegagalan tunggal. Saat infrastruktur tertekan, kegagalan berantai menyebar ke seluruh sistem yang sangat terhubung.

Protokol desentralisasi mendistribusikan state ke validator, mengeliminasi titik kegagalan tunggal. Blockchain throughput tinggi tetap mempertahankan properti ini saat outage (dana tidak hilang, hanya liveness sementara terganggu). Namun konsensus di validator terdistribusi menambah overhead komputasi. Validator harus sepakat sebelum state difinalisasi. Jika validator menjalankan versi tidak kompatibel atau overload traffic, proses konsensus bisa terhenti sementara.

Penambahan replika meningkatkan toleransi kegagalan namun menambah biaya koordinasi. Setiap validator tambahan di sistem Byzantine fault-tolerant menambah overhead komunikasi. Arsitektur throughput tinggi meminimalkan overhead melalui komunikasi validator yang efisien, menghasilkan kinerja superior namun rentan pada pola serangan tertentu. Arsitektur berfokus keamanan memprioritaskan keragaman validator dan ketahanan konsensus, membatasi throughput layer dasar demi resiliensi maksimal.

Solusi Layer 2 berupaya menghadirkan kedua properti lewat desain hierarkis. Mereka mewarisi keamanan Ethereum melalui settlement L1 sambil menawarkan throughput tinggi lewat komputasi off-chain. Namun, ini menciptakan bottleneck baru di layer sequencer dan RPC, menandakan kompleksitas arsitektur menghadirkan mode kegagalan baru meski mengatasi masalah lain.

Scaling Tetap Menjadi Masalah Fundamental

Insiden-insiden ini mengungkap pola konsisten: sistem menyiapkan beban normal, lalu gagal secara katastropik di bawah tekanan. Solana menangani traffic rutin secara efektif namun ambruk saat volume transaksi naik 10.000%. Biaya gas Ethereum tetap wajar hingga adopsi DeFi memicu kemacetan. Infrastruktur Optimism berjalan baik hingga 250.000 alamat serentak klaim airdrop. API Binance berfungsi dalam trading normal namun membatasi saat cascade likuidasi.

Event Oktober 2025 menunjukkan dinamika ini di tingkat bursa. Dalam operasi normal, pembatasan laju API dan koneksi database Binance sudah cukup. Saat cascade likuidasi, ketika seluruh trader mencoba menyesuaikan posisi secara bersamaan, pembatasan ini menjadi bottleneck. Sistem margin, yang dirancang untuk melindungi bursa lewat likuidasi paksa, justru memperparah krisis dengan menciptakan penjual paksa di saat terburuk.

Auto-scaling tak cukup melindungi dari lonjakan beban tiba-tiba. Penambahan server baru membutuhkan waktu beberapa menit. Selama waktu tersebut, sistem margin menandai posisi berdasarkan data harga yang rusak dari order book tipis. Saat kapasitas baru aktif, cascade telah menyebar.

Over-provisioning untuk event stres langka mahal dalam operasi normal. Operator bursa mengoptimalkan beban tipikal, menerima kegagalan sesekali sebagai keputusan ekonomi rasional. Biaya downtime dieksternalisasi ke pengguna yang mengalami likuidasi, transaksi macet, atau gagal akses dana pada momen krusial pasar.

Peningkatan Infrastruktur

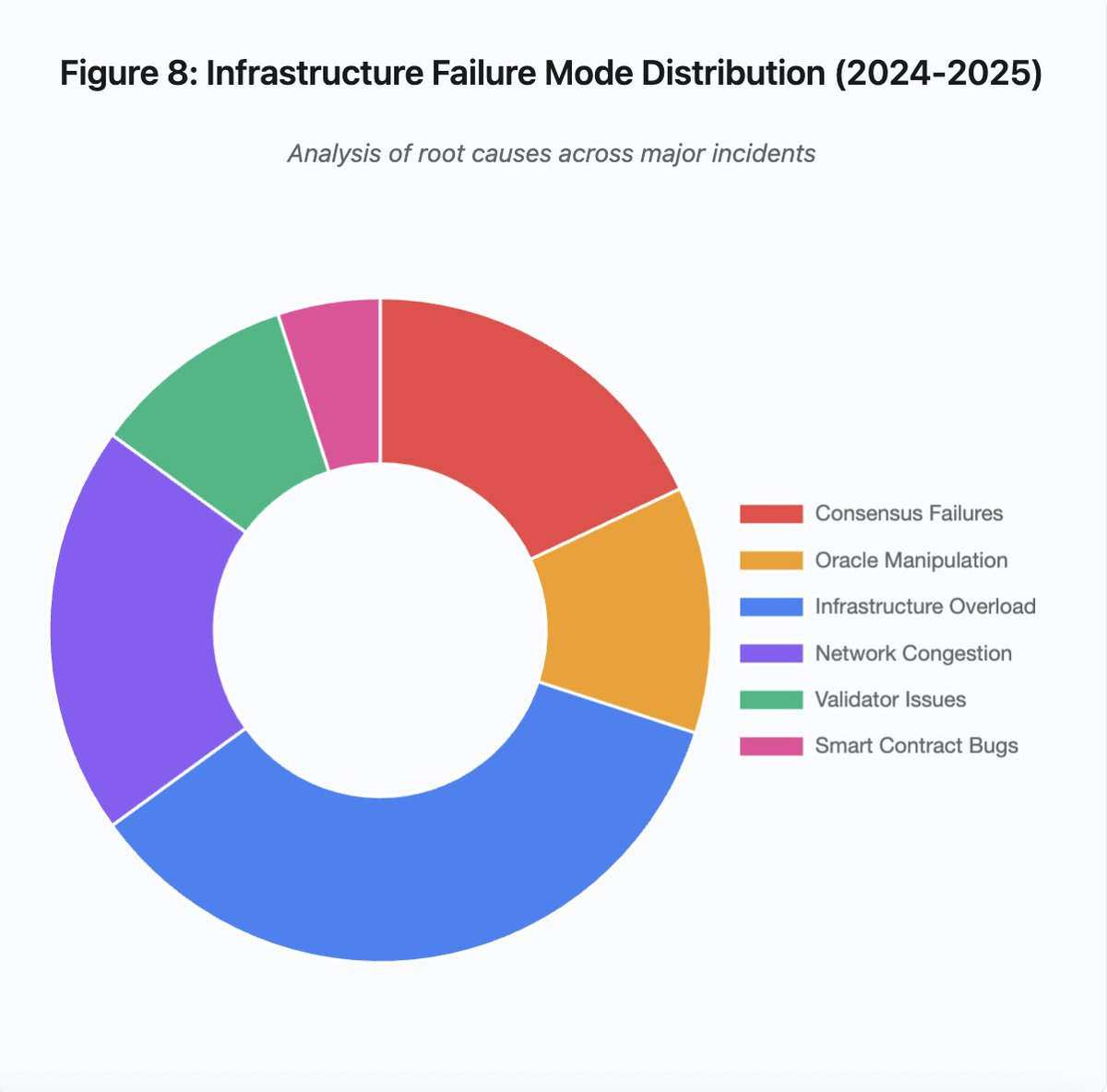

Gambar 8: Distribusi Mode Kegagalan Infrastruktur (2024–2025)

Diagram pie breakdown penyebab utama mengungkap:

- Overload Infrastruktur: 35% (terbanyak)

- Kemacetan Jaringan: 20%

- Kegagalan Konsensus: 18%

- Manipulasi Oracle: 12%

- Masalah Validator: 10%

- Bug Smart Contract: 5%

Beberapa perubahan arsitektural dapat menurunkan frekuensi dan tingkat keparahan kegagalan, namun masing-masing melibatkan trade-off:

1. Pemisahan Sistem Harga dan Likuidasi

Masalah Oktober sebagian berasal dari pengaitan margin ke harga spot. Penggunaan rasio konversi untuk aset wrapped, bukan harga spot, akan mencegah salah harga wBETH. Secara umum, sistem manajemen risiko kritis sebaiknya tidak bergantung pada data pasar yang berpotensi dimanipulasi. Sistem oracle independen dengan agregasi multi-sumber dan kalkulasi TWAP menyediakan feed harga yang lebih kuat.

2. Over-Provisioning dan Infrastruktur Redundan

Outage AWS April 2025 yang memengaruhi Binance, KuCoin, dan MEXC menunjukkan risiko konsentrasi infrastruktur. Menjalankan komponen kritis di beberapa provider cloud meningkatkan kompleksitas dan biaya operasional, tetapi menghilangkan kegagalan terkoordinasi. Jaringan Layer 2 dapat memiliki beberapa provider RPC dengan failover otomatis. Biaya tambahan tampak sia-sia dalam operasi normal, namun mencegah downtime berjam-jam saat permintaan puncak.

3. Pengujian Stres dan Perencanaan Kapasitas yang Ditingkatkan

Pola sistem berjalan baik hingga gagal menunjukkan pengujian stres yang kurang memadai. Simulasi beban 100x seharusnya menjadi standar. Mengidentifikasi bottleneck di tahap pengembangan jauh lebih efisien daripada menemukannya saat outage nyata. Namun pengujian beban realistis tetap menantang. Traffic produksi menunjukkan pola yang tidak bisa sepenuhnya direplikasi secara sintetis. Perilaku pengguna berbeda saat crash nyata dibandingkan uji coba.

Masa Depan

Over-provisioning adalah solusi paling solid namun bertentangan dengan insentif ekonomi. Menjaga kapasitas 10x lipat untuk event langka berarti biaya harian yang tinggi demi mencegah masalah yang terjadi satu kali setahun. Sampai kegagalan katastropik memaksa biaya cukup besar untuk membenarkan over-provisioning, sistem akan tetap gagal di bawah tekanan.

Tekanan regulasi bisa memaksa perubahan. Jika regulasi menuntut uptime 99,9% atau membatasi downtime yang dapat diterima, bursa harus over-provisioned. Namun regulasi biasanya lahir setelah bencana, bukan mencegahnya. Kolaps Mt. Gox 2014 mendorong regulasi bursa kripto di Jepang. Cascade Oktober 2025 kemungkinan akan memicu respons regulasi serupa. Apakah regulasi nanti menetapkan hasil (downtime maksimum, slippage maksimum saat likuidasi) atau implementasi (provider oracle spesifik, threshold circuit breaker) masih belum pasti.

Tantangan mendasar adalah sistem beroperasi nonstop di pasar global, namun bertumpu pada infrastruktur yang didesain untuk jam kerja tradisional. Saat tekanan terjadi pukul 02.00, tim harus berebut deploy perbaikan sementara pengguna mengalami kerugian. Pasar tradisional menghentikan trading saat krisis; pasar kripto justru kolaps. Apakah ini fitur atau bug tergantung perspektif dan posisi.

Sistem blockchain telah mencapai level teknis luar biasa dalam waktu singkat. Mempertahankan konsensus terdistribusi di ribuan node adalah pencapaian rekayasa nyata. Namun keandalan di bawah tekanan menuntut evolusi dari arsitektur prototipe ke infrastruktur produksi. Transisi ini mahal dan memerlukan prioritas pada robustness daripada kecepatan pengembangan fitur.

Masalah utama adalah memprioritaskan robustness di masa bull market ketika semua profit dan downtime terasa sebagai masalah orang lain. Ketika siklus berikutnya menguji sistem, kelemahan baru akan muncul. Apakah industri belajar dari Oktober 2025 atau mengulang pola yang sama masih terbuka. Sejarah menunjukkan kerentanan kritis berikutnya akan ditemukan melalui kegagalan multi-miliar berikutnya di bawah tekanan.

Analisis berdasar data pasar publik dan pernyataan platform. Seluruh pendapat merupakan milik penulis dan tidak mewakili entitas mana pun.

Disclaimer:

- Artikel ini merupakan reprint dari [yq_acc]. Seluruh hak cipta milik penulis asli [yq_acc]. Jika terdapat keberatan atas reprint ini, silakan hubungi tim Gate Learn untuk penanganan lebih lanjut.

- Disclaimer Tanggung Jawab: Pendapat dan opini dalam artikel ini sepenuhnya milik penulis dan tidak merupakan saran investasi apa pun.

- Terjemahan artikel ke bahasa lain dilakukan oleh tim Gate Learn. Kecuali dinyatakan secara eksplisit, dilarang menyalin, mendistribusikan, atau memplagiasi artikel terjemahan ini.

Artikel Terkait

Apa itu Tronscan dan Bagaimana Anda Dapat Menggunakannya pada Tahun 2025?

Apa itu USDC?

Apa itu Stablecoin?

Apa Itu Narasi Kripto? Narasi Teratas untuk 2025 (DIPERBARUI)

Penggunaan Bitcoin (BTC) di El Salvador - Analisis Keadaan Saat Ini